Въведение в чантиране и подсилване

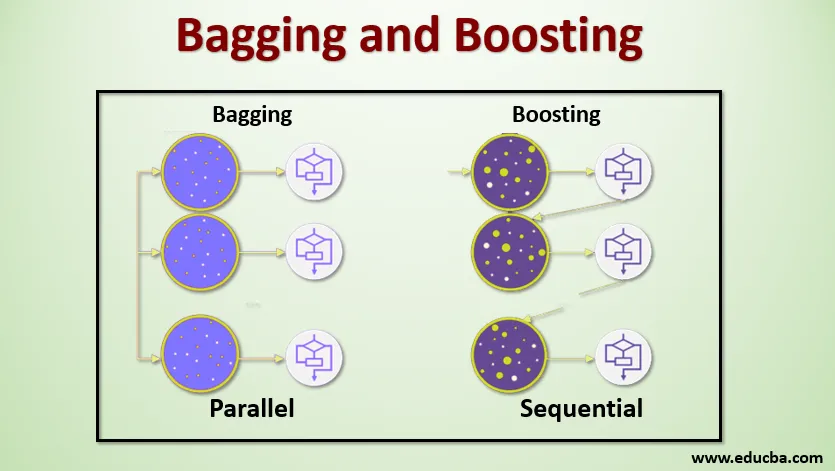

Багаж и усилване са двата популярни метода на ансамбъла. Така че преди да разберем Bagging и Boosting, нека да имаме представа какво е ансамбъл Learning. Техниката е да се използват множество алгоритми за обучение за обучение на модели с един и същ набор от данни, за да се получи прогноза в машинното обучение. След получаване на прогнозата от всеки модел ще използваме техники за усредняване на модела като средно претеглена стойност, дисперсия или максимум гласуване, за да получим окончателното прогнозиране. Този метод има за цел да получи по-добри прогнози от индивидуалния модел. Това води до по-добра точност, като се избягва прекомерното приспособяване и се намалява пристрастието и колебанията. Два популярни метода за ансамбъл са:

- Чантиране (Bootstrap агрегиране)

- Увеличаване

зебло:

Багажът, известен още като Bootstrap Aggregating, се използва за подобряване на точността и прави модела по-обобщен чрез намаляване на дисперсията, т.е. като се избягва прекаляването. В това отношение вземаме множество подмножества от базата данни за обучение. За всеки подмножество ние вземаме модел със същите алгоритми на обучение като дърво на решения, логистична регресия и др., За да прогнозираме изхода за един и същ набор от тестови данни. След като имаме прогнозиране от всеки модел, тогава използваме техника за усредняване на модела, за да получим крайния резултат от прогнозирането. Една от известните техники, използвани в Baging е Random Forest . В Случайната гора използваме множество дървета за решения.

Повишаване :

Увеличаването се използва предимно за намаляване на пристрастията и различията в контролираната техника на обучение. Той се отнася до семейството на алгоритъм, който преобразува слабите учащи се (базови учащи се) в силни учащи се. Слабият ученик са класификаторите, които са коректни само в малка степен с реалната класификация, докато силните учащи са класификаторите, които са добре свързани с реалната класификация. Малко известни техники на Boosting са AdaBoost, GRADIENT BOOSTING, XgBOOST (Extreme Gradient Boosting). Така че сега знаем какво представляват опаковането и усилването и какви са техните роли в машинното обучение.

Работа на чантиране и подсилване

Сега нека разберем как работи пакетирането и усилването:

зебло

За да разберем работата на Baging, приемем, че имаме N брой модели и набор данни D. Къде m е броят на данните и n е броят на характеристиките във всяка информация. И ние трябва да правим двоична класификация. Първо ще разделим набора от данни. Засега ще разделим този набор от данни само на набор от обучения и тестове. Нека наречем набора от данни за обучение, където е общият брой примери за обучение.

Вземете извадка от записи от тренировъчния комплект и го използвайте за обучение на първия модел, например m1. За следващия модел m2 повторно пригответе тренировъчния комплект и вземете друга проба от тренировъчния комплект. Ще направим същото за N броя на моделите. Тъй като пренастрояваме набора от данни за обучение и вземаме извадките от него, без да премахваме нищо от набора от данни, може да е възможно да имаме два или повече записа на данни за тренировки, често срещани в множество проби. Тази техника на повторно оформяне на набора от данни за обучение и предоставяне на извадката на модела се нарича „Row Sampling with Replacement“. Да предположим, че сме обучили всеки модел и сега искаме да видим прогнозата на тестовите данни. Тъй като ние работим върху изход от двоична класификация, може да бъде или 0, или 1. Тестовият набор данни се предава на всеки модел и получаваме прогноза от всеки модел. Да приемем, че от N модели повече от N / 2 модели прогнозираха, че е 1, Следователно, използвайки техниката за усредняване на модела като максимален вот, можем да кажем, че прогнозираният изход за тестовите данни е 1.

Увеличаване

При усилването ние вземаме записи от набора от данни и ги предаваме последователно на базата на учащите, тук базовите учащи могат да бъдат всеки модел. Да предположим, че имаме m брой записи в набора от данни. След това предаваме няколко записа на базата на обучаемия BL1 и го обучаваме. След като BL1 се обучава, след това предаваме всички записи от набора от данни и виждаме как работи базовият ученик. За всички записи, които са класифицирани неправилно от базовия обучаем, ние ги вземаме само и ги предаваме на друг обучаем на базата казва BL2 и едновременно предаваме грешните записи, класифицирани от BL2, за да обучаваме BL3. Това ще продължи, освен ако и докато не посочим конкретен брой базови модели обучаващи се, които ни трябват. И накрая, ние комбинираме резултата от тези базови учащи се и създаваме силен обучаем, в резултат на това силата на прогнозиране на модела се подобрява. Добре. Така че сега знаем как работят Baging and Boost.

Предимства и недостатъци на чантиране и подсилване

По-долу са дадени основните предимства и недостатъци.

Предимства на Backing

- Най-голямото предимство на пакетирането е, че много слаби учащи могат да работят по-добре от един силен обучаем.

- Той осигурява стабилност и увеличава точността на алгоритъма за машинно обучение, който се използва в статистическата класификация и регресия.

- Той помага за намаляване на дисперсията, т.е. избягва прекаляването.

Недостатъци на чантата

- Това може да доведе до големи пристрастия, ако не е моделирано правилно и по този начин може да доведе до недостиг.

- Тъй като трябва да използваме няколко модела, той става изчислително скъп и може да не е подходящ в различни случаи на употреба.

Предимства на стимулирането

- Това е една от най-успешните техники за решаване на двукласните класификационни проблеми.

- Добре е да боравите с липсващите данни.

Недостатъци на подсилването

- Увеличаването е трудно осъществимо в реално време поради повишената сложност на алгоритъма.

- Високата гъвкавост на тези техники води до множество параметри, отколкото имат пряк ефект върху поведението на модела.

заключение

Основното поведение е, че Bagging и Boosting са парадигма за машинно обучение, в която използваме множество модели, за да решим един и същ проблем и да постигнем по-добро представяне. В тази статия съм дал основен преглед на Baging и Boost. В следващите статии ще се запознаете с различните техники, използвани и в двете. Накрая ще завърша, като ви припомня, че Bagging и Boosting са сред най-използваните техники на ансамбълното обучение. Истинското изкуство за подобряване на производителността се крие в разбирането ви за това кога да използвате кой модел и как да настроите хиперпараметрите.

Препоръчителни статии

Това е ръководство за Baging и Boost. Тук обсъждаме Въвеждането на чантирането и усилването и работи заедно с предимствата и недостатъците. Можете да разгледате и другите ни предложени статии, за да научите повече -

- Въведение в ансамбълните техники

- Категории на алгоритми за машинно обучение

- Алгоритъм за усилване на градиента с примерен код

- Какво е алгоритъмът за усилване?

- Как да създадете дърво на решения?