Разлика между Hadoop и Elasticsearch

Hadoop е рамка, която помага за боравене с обемните данни за части от секунди, където традиционните начини не успяват да се справят. Необходима е поддръжката на множество машини, за да стартира процеса паралелно разпределено. Elasticsearch работи като сандвич между Logstash и Kibana. Когато Logstash е отговорен за извличане на данни от всеки източник на данни, еластичното търсене анализира данните и накрая, kibana дава полезна информация за това. Това решение прави приложенията по-мощни за работа в сложни изисквания или изисквания.

Сега нека очакваме подробно темата:

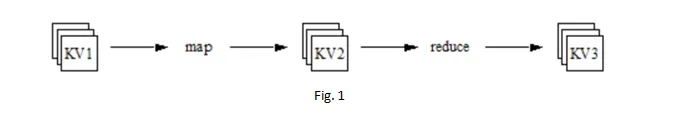

Уникалният му начин на управление на данните (специално проектиран за Big data), който включва краен процес на съхранение, обработка и анализ. Този уникален начин е наречен MapReduce. Разработчиците пишат програмите в рамките на MapReduce, за да изпълняват паралелно обширните данни в разпределени процесори.

Тогава възниква въпросът, след като данните се разпределят за обработка в различни машини, как продукцията се натрупва по подобен начин?

Отговорът е, че MapReduce генерира уникален ключ, който се добавя с разпределени данни в различни машини. MapReduce следи обработката на данни. И след като е направено, този уникален ключ се използва за събиране на всички обработени данни. Това дава усещането за цялата работа, извършена на една машина.

Мащабируемостта и надеждността се грижат перфектно в MapReduce of Hadoop. По-долу са някои функционалности на MapReduce:

- След това картата Намаляване: За да стартирате работа, тя се разбива на отделни парчета, които се наричат задача. Функцията Mapper винаги ще се изпълнява първо за всички задачи, след това само функцията за намаляване ще влезе в картината. Целият процес ще бъде наречен завършен, само когато функцията за намаляване завърши работата си за всички разпределени задачи.

- Fale Tolerant: Вземете сценарий, когато един възел се спуска надолу, докато обработва задачата? Сърдечният пулс на този възел не достига до двигателя на MapReduce или казват Master възел. Тогава, в този случай, Master възелът възлага тази задача на някакъв различен възел, за да завърши задачата. Нещо повече, необработените и обработени данни се съхраняват в HDFS (Hadoop Distributed File System), който е слой за съхранение на Hadoop с фактор на репликация по подразбиране 3. Това означава, че ако един възел се спуска, все още има два възела живи със същите данни.

- Гъвкавост: Можете да съхранявате всякакъв тип данни: структурирани, полуструктурирани или неструктурирани.

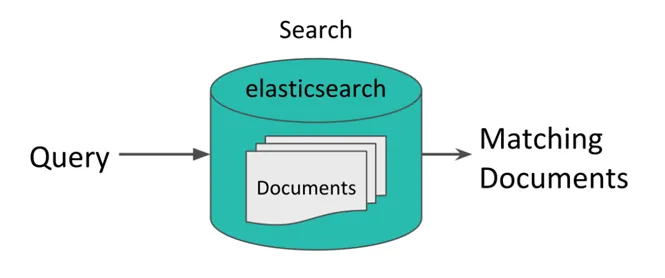

- Синхронизация: Синхронизацията е вградена характеристика на Hadoop. Това гарантира, че намаляването ще започне само ако цялата функция на картографира се изпълнява със задачата му. „Разбъркване“ и „Сортиране“ е механизмът, който прави изхода на работата по-гладък. Elasticsearch е базиран на JSON прост, но мощен аналитичен инструмент за индексиране на документи и мощно пълнотекстово търсене.

Фиг. 2

В ELK всички компоненти са с отворен код. ELK взима голяма скорост в ИТ среда за анализ на журнали, уеб анализи, бизнес разузнаване, анализ на съответствие и др. ELK е подходящ за бизнес, където идват ad hoc заявки и данните трябва бързо да бъдат анализирани и визуализирани.

ELK е чудесен инструмент за стартиране на Tech, които не могат да си позволят да закупят лиценз за продукт за анализ на журнали като Splunk. Освен това продуктите с отворен код винаги са били в центъра на вниманието на ИТ индустрията.

Сравнения между главата на Hadoop срещу Elasticsearch (Инфографика)

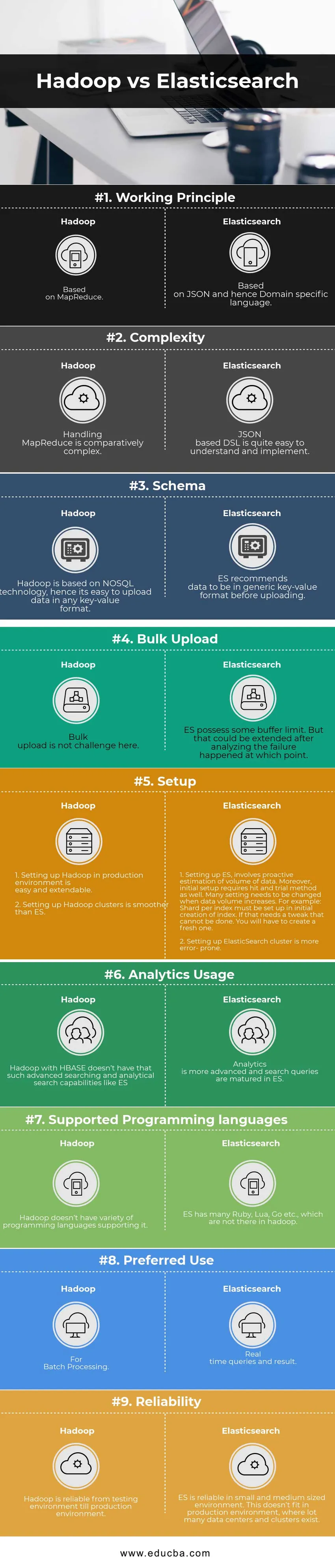

По-долу са първите 9 сравнения между Hadoop и Elasticsearch

Ключова разлика между Hadoop срещу Elasticsearch

Ключова разлика между Hadoop срещу Elasticsearch

По-долу са списъците с точки, опишете ключовите разлики между Hadoop и Elasticsearch:

- Hadoop има разпределена файлова система, която е предназначена за паралелна обработка на данни, докато ElasticSearch е търсачката.

- Hadoop осигурява много по-голяма гъвкавост с различни инструменти в сравнение с ES.

- Hadoop може да съхранява множество данни, докато ES не може.

- Hadoop може да се справи с обширна обработка и сложна логика, където ES може да се справи само с ограничена обработка и основна логика на агрегиране.

Таблица за сравнение на Hadoop срещу Elasticsearch

| Основа за сравнение | Hadoop | Elasticsearch |

| Принцип на работа | Въз основа на MapReduce | Въз основа на JSON и следователно език, специфичен за домейна |

| Сложност | Работата с MapReduce е сравнително сложна | DSL базиран DSL е доста лесен за разбиране и прилагане |

| схема | Hadoop се основава на технологията NoSQL, следователно е лесно да се качват данни във всеки формат ключ-стойност | ES препоръчва данните да бъдат в общ формат ключ-стойност, преди да се качват |

| Групово качване | Тук груповото качване не е предизвикателство | ES притежават някакъв лимит на буфер. Но това може да се разшири, след като в този момент се направи анализ на грешката. |

| Настройвам | 1.Настройването на Hadoop в производствена среда е лесно и разширимо.

2. Настройката на кластери Hadoop е по-гладка от ES. | 1.Настройването на ES включва проактивна оценка на обема на данните. Нещо повече, първоначалната настройка изисква и метод за изпробване и изпробване. Много настройки трябва да бъдат променени, когато обемът на данните се увеличи. Например Shard per index трябва да бъде настроен при първоначалното създаване на индекс. Ако това се нуждае от ощипване, което не може да се направи. Ще трябва да създадете свеж.

2.Настройването на клъстера ElasticSearch е по-податливо на грешки. |

| Използване на Google Анализ | Hadoop с HBase няма такива възможности за разширено търсене и аналитично търсене като ES | Анализът е по-напреднал и заявките за търсене са узрели в ES |

| Поддържани езици за програмиране | Hadoop няма разнообразни езици за програмиране, които го поддържат. | ES има много Ruby, Lua, Go и т.н., които не са там в Hadoop |

| Предпочитана употреба | За пакетна обработка | Въпроси в реално време и резултат |

| надеждност | Hadoop е надежден от тестова среда до производствена среда | ES е надежден в малка и средна среда. Това не се вписва в производствена среда, където има много центрове за данни и клъстери. |

Заключение - Hadoop срещу Elasticsearch

В крайна сметка това всъщност зависи от типа данни, обема и случая на използване, върху който се работи. Ако фокусът е простото търсене и уеб анализи, тогава е по-добре да се работи с Elasticsearch. Докато ако има голямо търсене на мащабиране, обем от данни и съвместимост с инструменти на трети страни, Hadoop инстанцията е отговорът на това. Въпреки това интеграцията на Hadoop с ES отваря нов свят за тежки и големи приложения. Използването на пълна мощност от Hadoop и Elasticsearch може да даде добра платформа за обогатяване на максимална стойност от големите данни.

Препоръчани статии:

Това е ръководство за Hadoop срещу Elasticsearch, тяхното значение, сравнение между главата, ключови разлики, таблица на сравнението и заключение. Можете също да разгледате следните статии, за да научите повече -

- Как да разчупите въпроси за интервю за разработчика на Hadoop

- Hadoop срещу Apache Spark

- HADOOP срещу RDBMS | Познайте 12-те полезни разлики

- Как да разбиете интервюто за разработчици на Hadoop?

- Защо иновациите са най-критичният аспект на големите данни?

- Най-доброто ръководство за Hadoop срещу Spark