Преглед на Инсталиране на Hadoop

Следващата статия, Инсталиране на Hadoop предоставя очертание на най-често срещаните ключови модули на рамката на Hadoop и поетапна инсталация за Hadoop. Apache Hadoop е колекция от софтуер, който дава възможност за обработка на големи набори от данни и разпределено съхранение в клъстер от различни видове компютърна система. Понастоящем Hadoop остава най-използваната платформа за анализ на големи данни („Sanchita Lobo, Author at Blog Training Training“, nd).

Hadoop Framework

Рамката Apache Hadoop се състои от следните ключови модули.

- Apache Hadoop Common.

- Разпределена файлова система на Apache Hadoop (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (още един мениджър на ресурси).

Apache Hadoop Common

Apache Hadoop Common модул се състои от споделени библиотеки, които се консумират във всички останали модули, включително управление на ключове, общи I / O пакети, библиотеки за събиране на показатели и помощни програми за системния регистър, сигурност и стрийминг.

HDFS

HDFS е базиран на файловата система на Google и е структуриран да работи на хардуер с ниска цена. HDFS е толерантен към грешки и е предназначен за приложения с големи набори от данни.

MapReduce

MapReduce е присъщ модел на паралелно програмиране за обработка на данни и Hadoop може да стартира MapReduce програми, написани на различни езици, като Java. MapReduce работи, като разделя обработката на фазата на картата и намалява фазата.

Apache Hadoop ПРЪЖДА

Apache Hadoop YARN е основен компонент и е управление на ресурсите и технологията за планиране на задачи в рамките на разпределената обработка на Hadoop.

В тази статия ще обсъдим инсталирането и конфигурацията на Hadoop 2.7.4 на един възел клъстер и ще тестваме конфигурацията, като стартирате програмата MapReduce, наречена wordcount, за да преброите броя на думите във файла. По-нататък ще разгледаме няколко важни команди Hadoop File System.

Стъпки за инсталиране на Hadoop

Следва резюме на задачите, включени в конфигурацията на Apache Hadoop.

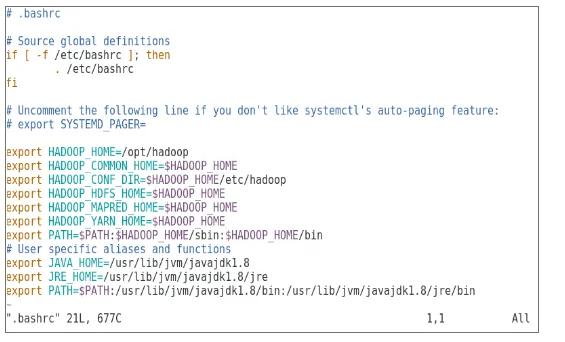

Задача 1: Първата задача в инсталацията на Hadoop включва настройка на шаблон за виртуална машина, който е конфигуриран с Cent OS7. Пакети като Java SDK 1.8 и Runtime Systems, необходими за стартиране на Hadoop, бяха изтеглени и Java променлива среда за Hadoop беше конфигурирана чрез редактиране на bash_rc.

Задача 2: Пакетът Hadoop Release 2.7.4 беше изтеглен от уебсайта apache и беше извлечен в папката opt. Което след това беше преименувано на Hadoop за лесен достъп.

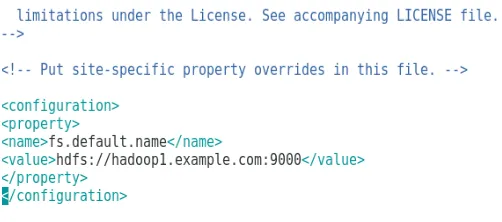

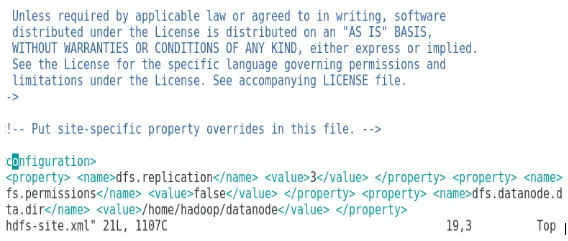

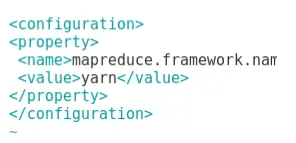

Задача 3: След извличането на пакетите Hadoop следващата стъпка включва конфигуриране на променливата на средата за потребителя на Hadoop, последвана от конфигуриране на XML файлове на възел Hadoop. В този етап NameNode е конфигуриран в рамките на core-site.xml, а DataNode е конфигуриран в рамките на hdfs-site.xml. Мениджърът на ресурси и мениджърът на възли бяха конфигурирани в преждата-site.xml.

Задача 4: Защитната стена е деактивирана, за да стартирате YARN и DFS. JPS командата се използва за проверка дали съответните демони се изпълняват на заден план. Номерът на порта за достъп до Hadoop е конфигуриран за http: // localhost: 50070 /

Задача 5: Следващите няколко стъпки бяха използвани за проверка и тестване на Hadoop. За това създадохме временен тестов файл във входната директория за програма WordCount. Програмата за намаляване на картите Hadoop-MapReduce-example2.7.4.jar беше използвана за преброяване на броя думи във файла. Резултатите бяха оценени на localhost и бяха анализирани дневниците на подаденото заявление. Всички подадени приложения MapReduce могат да се видят в онлайн интерфейса, като портомерен номер на порта е 8088.

Задача 6: В последната задача ще представим някои основни команди Hadoop File System и ще проверим използванията им. Ще видим как може да бъде създадена директория във файловата система Hadoop, да изброим съдържанието на директория, нейния размер в байтове. По-нататък ще видим как да изтрием конкретна директория и файл.

Резултати при инсталиране на Hadoop

Следното показва резултатите от всяка от горните задачи:

Резултат от задача 1

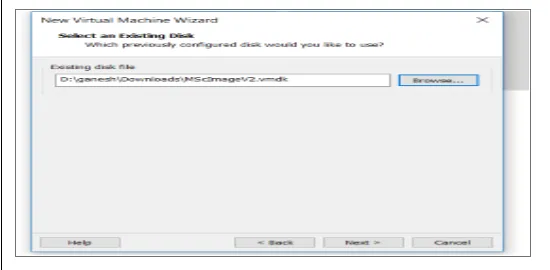

Нова виртуална машина с изображение на cenOS7 е конфигурирана да работи Apache Hadoop. Фигура 1 показва как изображението на CenOS 7 е конфигурирано във виртуалната машина. Фигура 1.2 показва конфигурацията на променливата на средата на JAVA в .bash_rc.

Фигура 1: Конфигурация на виртуална машина

Фигура 1.2: Конфигурация на променлива среда на Java среда

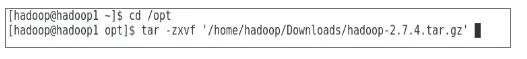

Резултат от задача 2

Фигура 2 показва задачата, изпълнена с цел извличане на пакета Hadoop 2.7.4, за да изберете папката.

Фигура 2: Екстракция на пакет Hadoop 2.7.4

Резултат от задача 3

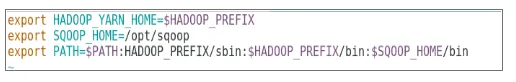

Фигура 3 показва конфигурацията на променливата на средата за потребител на Hadoop, фигури 3.1 до 3.4 показва конфигурацията за XML файлове, необходими за конфигурация на Hadoop.

Фигура 3: Конфигуриране на променлива среда за потребител на Hadoop

Фигура 3.1: Конфигурация на core-site.xml

Фигура 3.2: Конфигурация на hdfs-site.xml

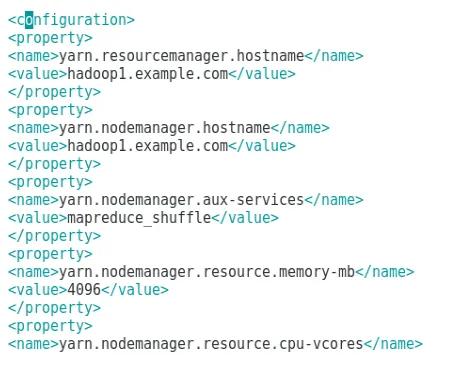

Фигура 3.3: Конфигурация на файл mapred-site.xml

Фигура 3.4: Конфигурация на файл с прежда-site.xml

Резултат от задача 4

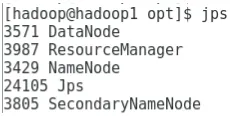

Фигура 4 показва използването на командата jps за проверка на съответни демони, които се изпълняват на заден план, а следващата фигура показва онлайн потребителския интерфейс на Hadoop.

Фигура 4: jps команда за проверка на работещи демони.

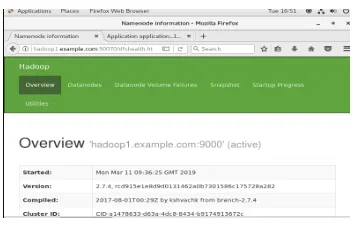

Фигура 4.1: Достъп до онлайн интерфейс на Hadoop на пристанището http://hadoop1.example.comwhat0070/

Резултат от задача 5

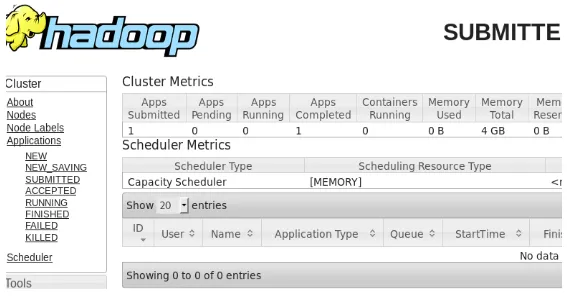

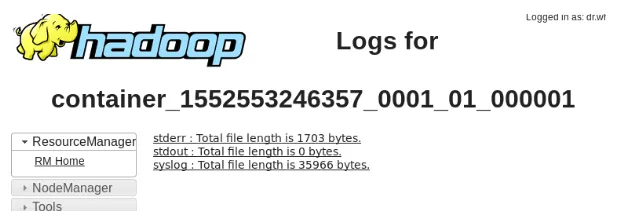

Фигура 5 показва резултата за програмата MapReduce, наречена wordcount, която отчита броя на думите във файла. Следващите няколко фигури показват онлайн потребителския интерфейс на мениджъра на ресурси на YARN за подадената задача.

Фигура 5: Резултати от програмата MapReduce

Фигура 5.1: Изпратено приложение за намаляване на картата.

Фигура 5.2: Дневници за подадено приложение MapReduce.

Резултат от задача 6

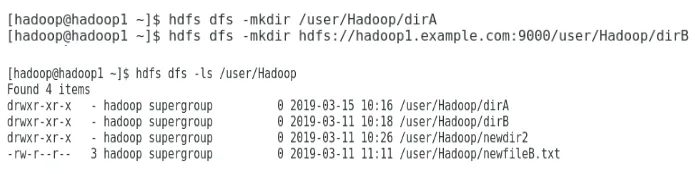

Фигура 6 показва как да създадете директория в файловата система Hadoop и да извършите списък на директория hdfs.

Фигура 6: Създаване на директория в рамките на файловата система Hadoop

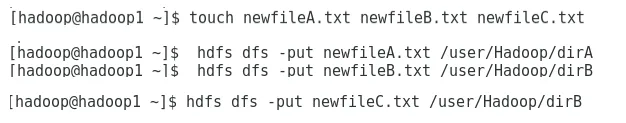

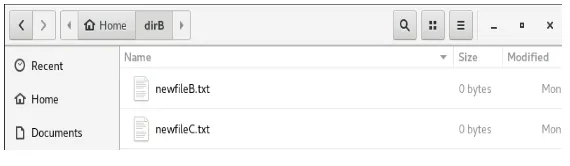

Фигура 6.1 показва как да поставите файл върху разпределената файлова система Hadoop, а фигура 6.2 показва създадения файл в директорията dirB.

Фигура 6.1: Създаване на файл в HDFS.

Фигура 6.2: Създаден е нов файл.

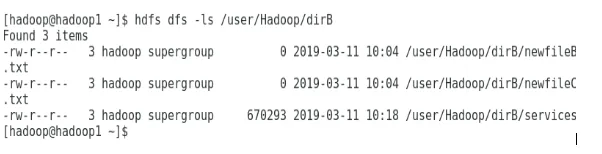

Следващите няколко фигури показват как да изброите съдържанието на конкретни директории:

Фигура 6.3: Съдържание на dirA

Фигура 6.4: Съдържание на dirB

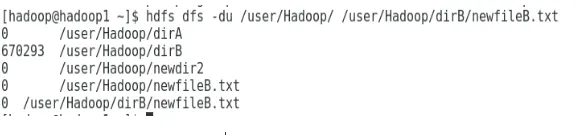

Следващата фигура показва как може да се покаже размера на файла и директория:

Фигура 6.5: Показване на размер на файл и директория.

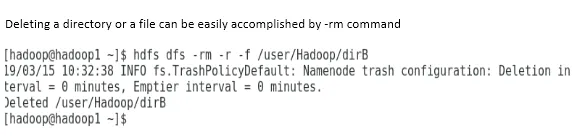

Изтриването на директория или файл може лесно да се осъществи чрез команда -rm.

Фигура 6.6: За да изтриете файл.

заключение

Big Data изигра много важна роля при формирането на днешния световен пазар. Рамка Hadoop улеснява живота на анализатора на данни, докато работи върху големи набори от данни. Конфигурацията на Apache Hadoop беше доста проста и онлайн потребителският интерфейс предоставя на потребителя множество опции за настройване и управление на приложението. Hadoop се използва масово в организациите за съхранение на данни, анализи за машинно обучение и архивиране на данни. Управлението на голям обем от данни е доста удобно поради разпространената среда на Hadoop и MapReduce. Разработката на Hadoop беше доста невероятна в сравнение с релационните бази данни, тъй като им липсват възможности за настройка и производителност. Apache Hadoop е удобно за потребителя и евтино решение за ефективно управление и съхранение на големи данни. HDFS също оказва дълъг път в подпомагането на съхранението на данни.

Препоръчителни статии

Това е ръководство за инсталиране на Hadoop. Тук обсъждаме въвеждането на Instal Hadoop, стъпка по стъпка инсталация на Hadoop, заедно с резултатите от инсталирането на Hadoop. Можете да разгледате и другите ни предложени статии, за да научите повече -

- Въведение в Hadoop Streaming

- Какво е клъстер Hadoop и как работи?

- Екосистема Apache Hadoop и нейните компоненти

- Какви са алтернативите на Hadoop?