Какво е Big Data Technology?

Както знаем, данните се развиват постоянно. Нарастването на данните предизвика човешкия ум да извлече, анализира и да се справи с това. Това е така, защото традиционните начини за справяне с данните не успяват да подкрепят тези големи данни. Големите данни се описват обикновено от три понятия: обем, разнообразие и скорост.

Данните вече са станали най-важният актив на всяка компания. Анализът на тези големи данни помага на компанията да анализира поведението на клиента си и да прогнозира съответните неща, свързани с тези решения, базирани на данни, да направи организацията, да предприеме по-уверени ходове и да изгради по-силни стратегии.

Познавайки темповете, с които данните се увеличават в днешната ера, големите данни ще бъдат гигантско поле в близко бъдеще, за което да работим. Ще са необходими всички студенти, по-нови специалисти, професионалисти, за да бъдат в крак с новите технологии за големи данни. Актуализирането на себе си ще донесе страхотна и успешна кариера в професионалния път.

Технологии за големи данни

Тук изброявам няколко големи технологии за данни с ясно обяснение, за да ви информират за предстоящите тенденции и технологии:

-

Apache Spark:

Това е бърз двигател за обработка на големи данни. Това е изградено, като се има предвид обработката на данни в реално време. Богатата му библиотека за машинно обучение е добре да работи в пространството на AI и ML. Той обработва данни паралелно и на клъстерирани компютри. Основният тип данни, използван от Spark, е RDD (еластичен разпределен набор от данни).

-

NoSQL бази данни:

Това е нереляционни бази данни, които осигуряват бързо съхранение и извличане на данни. Способността му да се справя с всякакъв вид данни като структурирани, полуструктурирани, неструктурирани и полиморфни данни е уникална. Няма SQL бази данни са от следните видове:

- Бази данни за документи : Съхранява данни под формата на документи, които могат да съдържат много различни двойки ключ-стойност.

- Графични магазини : Той съхранява данни, които обикновено се съхраняват под формата на мрежа, като например данни от социалните медии.

- Ключови стойности : Това са най-простите бази данни NoSQL. Всеки един елемент в базата данни се съхранява като име на атрибут (или 'ключ'), заедно със стойността му.

- Магазини с широки колони : Тази база данни съхранява данни в колонен формат, а не във формат, базиран на редове. Касандра и HBase са добри примери за това.

-

Apache Kafka:

Kafka е разпределена платформа за стрийминг на събития, която обработва много събития всеки ден. Тъй като е бързо и мащабируемо, това е полезно при изграждането на поточни тръбопроводи за поточно предаване в реално време, които надеждно извличат данни между системи или приложения.

-

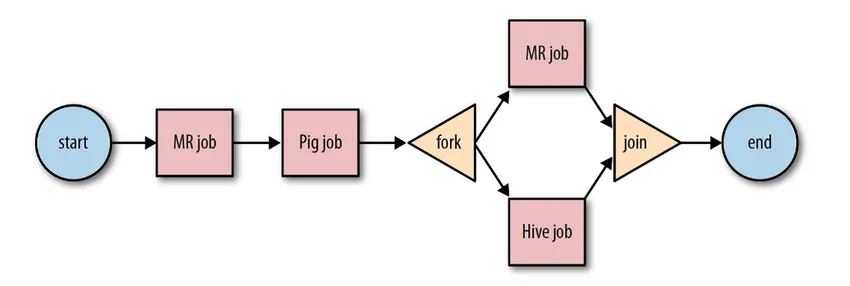

Apache Oozie:

Това е система за планиране на работния процес за управление на заданията на Hadoop. Тези работни задачи се планират под формата на насочени ациклични графики (DAGs) за действия.

Източник: Google

Мащабираното и организирано решение за дейности с големи данни.

-

Apache Airflow:

Това е платформа, която планира и следи работния процес. Интелигентното планиране помага за ефективно организиране на крайното изпълнение на проекта. Въздушният поток притежава възможността за повторно стартиране на DAG екземпляр, когато има случай на повреда. Неговият богат потребителски интерфейс улеснява визуализацията на тръбопроводи, работещи в различни етапи, като производство, следене на напредъка и отстраняване на проблеми при необходимост.

-

Apache Beam:

Това е унифициран модел за определяне и изпълнение на тръбопроводи за обработка на данни, които включват ETL и непрекъснато поточно предаване. Рамката Apache Beam осигурява абстракция между вашата логика на приложение и екосистемата с големи данни, тъй като няма API, който да обвързва всички рамки като Hadoop, искра и т.н.

-

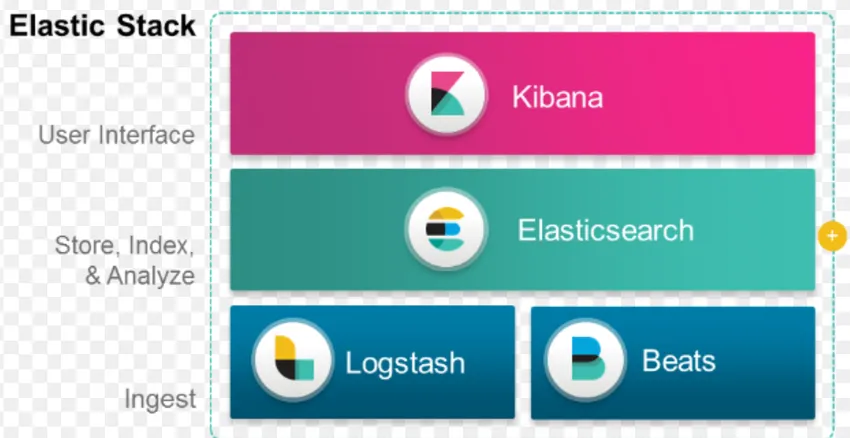

ELK стек:

ELK е известен с Elasticsearch, Logstash и Kibana.

Elasticsearch е база данни без схеми (която индексира всяко едно поле), която има мощни възможности за търсене и лесно мащабируема.

Logstash е ETL инструмент, който ни позволява да извличаме, трансформираме и съхраняваме събития в Elasticsearch.

Kibana е инструмент за табло за Elasticsearch, където можете да анализирате всички съхранени данни. Действителните извлечения, извлечени от Кибана, помагат в изграждането на стратегии за организация. От улавянето на промените до прогнозирането, Кибана винаги се е оказал много полезен.

-

Docker & Kubernete:

Това са новите технологии, които помагат на приложенията да се изпълняват в Linux контейнери. Docker е колекция от инструменти с отворен код, които ви помагат да "изграждате, изпращате и стартирате всяко приложение, навсякъде".

Kubernetes е също платформа за контейнери / оркестрации с отворен код, позволяваща на голям брой контейнери да работят заедно в хармония. Това в крайна сметка намалява оперативната тежест.

-

TensorFlow:

Това е библиотека за машинно обучение с отворен код, която се използва за проектиране, изграждане и обучение на модели за дълбоко обучение. Всички изчисления се извършват в TensorFlow с графики на потока от данни. Графиките съдържат възли и ръбове. Възлите представляват математически операции, докато ръбовете представляват данните.

TensorFlow е полезен за изследвания и производство. Той е създаден като се има предвид, че може да работи на множество процесори или графични процесори и дори мобилни операционни системи. Това може да бъде реализирано в Python, C ++, R и Java.

-

Presto:

Presto е SQL двигател с отворен код, разработен от Facebook, който е в състояние да обработва петабайти от данни. За разлика от Hive, Presto не зависи от техниката MapReduce и следователно по-бързо при извличане на данните. Архитектурата и интерфейсът му са достатъчно лесни за взаимодействие с други файлови системи.

Поради ниската латентност и лесната интерактивна заявка, тя става много популярна в днешно време за работа с големи данни.

-

полиоснова:

Polybase работи върху SQL Server за достъп до данни, съхранявани в PDW (Parallel Data Warehouse). PDW създаден за обработка на всякакъв обем релационни данни и осигурява интеграция с Hadoop.

-

Hive:

Hive е платформа, използвана за заявки и анализ на данни при големи набори от данни. Той предоставя подобен на SQL език на заявките, наречен HiveQL, който вътрешно се преобразува в MapReduce и след това се обработва.

С бързия растеж на данните и огромния стремеж на организацията да анализира големите данни Технологията внесе на пазара толкова много зрели технологии, че познаването им е от огромна полза. В наши дни технологията за големи данни се справя с много бизнес нужди и проблеми, като повишава оперативната ефективност и предвижда съответното поведение. Кариерата в големите данни и свързаните с нея технологии могат да отворят много врати за възможности както за човека, така и за бизнеса.

Оттук нататък е крайно време да се приемат технологии за големи данни.

Препоръчителни статии

Това е ръководство за това какво е Big Data Technology. Тук сме обсъдили няколко технологии за големи данни като Hive, Apache Kafka, Apache Beam, ELK Stack и др. Можете също да разгледате следната статия, за да научите повече -

- Какво е дълбокото обучение?

- Пътеводител за Minitab?

- Какво представлява технологията Salesforce?

- Какво представлява анализа на големи данни?