Разлика между Hadoop и SQL

Огромните данни, генерирани всяка секунда чрез социални медии като Facebook, Twitter, Instagram, проправиха пътя за развитието на Hadoop / Big Data Ecosystem. Терминът „3V“, отнасящ се до обем, скорост и достоверност, определя значението на Hadoop за обработка на поточните данни. Днес данните се генерират от множество източници, които са необходими за интегриране за различни цели като отчитане, анализ на данни и изследвания и за централизирано съхранение на данни. Когато правим това, възникват множество проблеми с традиционните подходи като пространство, достъп, цялостност, структура и честотна лента. За да се справи с всички тези проблеми, Hadoop предоставя рамка, която дава възможност за обработка на данни с огромен размер, за осигуряване на лесен достъп, висока наличност и динамично зареждане на данни. Разполага с рамка за разпределена файлова система (HDFS) за съхранение на процесор за данни и вградени заявки, наречена „Намаляване на картата“ за анализ и обработка на данни, съхранявани в HDFS.

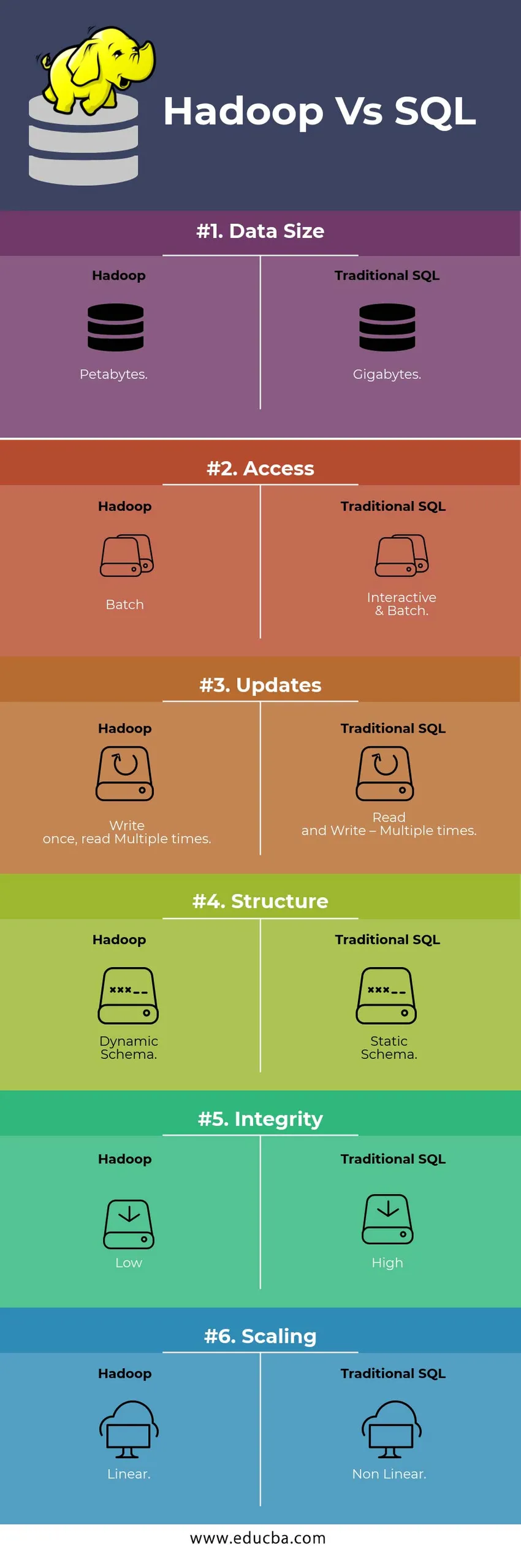

Сравнете HEAD TO HEAD Сравнение между Hadoop Vs SQL

По-долу е топ 6 разликата между Hadoop Vs SQL

Ключови разлики между Hadoop Vs SQL

По-долу е разликата между Hadoop и SQL, както следва

- Схема на WRITE VS ПРОЧЕТЕТЕ

Обикновено в традиционната база данни, по време на зареждане / миграция на данни от една база данни в друга, тя следва схема при подход на запис. Това прави процеса на зареждане на данни да се вълнува / прекъсва и води до отхвърляне на записи поради разлика в структурата на източника и целевите таблици, докато в системата на Hadoop всички данни се съхраняват в HDFS и данните са централизирани.

Рамка Hadoop се използва главно за процеса на анализ на данни. По този начин той поддържа и трите категории данни, т.е. Структурирани, полуструктурирани и неструктурирани данни и дава възможност за схема на подход за четене.

- Структурираните данни имат определен формат. ж .: XML файл.

- Данните за полуструктури са по-губи; Възможно е / да няма схема. г.: Електронна таблица

- Неструктурираните данни нямат конкретна структура или схема. Например: Обикновен текст или изображение.

Hadoop работи ефективно с неструктурирани данни, тъй като има възможност да интерпретира данните по време на обработката.

| Приближаване | предимство | Dis предимство |

| Схема за запис | · Предварително определени структури

· По-бързо четене. Например: Традиционни RDBMS. | Бавно зареждане на данни

Висока латентност |

| Схема на четене | · Динамична структура

· Бързо писане и четене. Например: Hadoop | Бързо зареждане на данни

Ниска латентност |

Таблица : Схема на WRITE VS схема на READ.

- СКАЛИВНОСТ И РАЗХОДИ

Hadoop Framework е предназначен за обработка на голям обем данни. Всеки път, когато размерът на данните се увеличава, редица допълнителни ресурси, като възел на данни, могат да бъдат добавени към клъстера много лесно, отколкото традиционното приближаване на разпределението на статично памет. Времето и бюджетът са сравнително много по-малко за тяхното изпълнение, а също така Hadoop осигурява локалност на данните, когато данните се предоставят в възела, изпълнил заданието.

- НЕОБХОДИМА ТОЛЕРАНЦИЯ

В традиционните RDBMS, когато данните се губят поради корупция или някакъв проблем с мрежата, са необходими повече време, разходи и ресурси, за да се върнат загубените данни. Но Hadoop има механизъм, при който данните имат минимум три нива на коефициент на репликация за данните, които се съхраняват в HDFS. Ако един от възлите на данни, който съхранява данни, се провали, данните могат лесно да бъдат изтеглени от други възли за данни с висока наличност на данни. Следователно прави данните лесно достъпни за потребителя, независимо от неизправност.

- ФУНКЦИОНАЛНО ПРОГРАМИРАНЕ

Hadoop поддържа писането на функционално програмиране на езици като java, scala и python. За всяко приложение, което изисква каквато и да е допълнителна функционалност, може да бъде реализирано чрез регистриране на UDF - потребителски дефинирани функции в HDFS. В RDBMS няма възможност за писане на UDF и това увеличава сложността на писане на SQL. Освен това данните, съхранявани в HDFS, могат да бъдат достъпни от цялата екосистема на Hadoop като Hive, Pig, Sqoop и HBase. Така че, ако е написан UDF, той може да се използва от всяко от горепосочените приложения. Повишава производителността и поддържането на системата.

- ОПТИМИЗАЦИЯ

Hadoop съхранява данни в HDFS и Process, въпреки намаляването на картата с огромни техники за оптимизация. Най-популярните техники, използвани за обработка на данни, са използването на дял и групиране на съхранените данни. Разделянето е подход за съхранение на данните в HDFS чрез разделяне на данните въз основа на колоната, спомената за разделяне. Когато данните се инжектират или се заредят в HDFS, той идентифицира колоната за дялове и избутва данните в съответната директория на дяловете. Така че заявката извлича резултата, като директно извлича данните от разделената директория. Това намалява сканирането на цялата таблица, подобрява времето за реакция и избягва закъсненията.

Друг подход се нарича Bucketing на данните. Това дава възможност на анализатора лесно да разпределя данните между възлите за данни. Всички възли ще имат равен брой разпределени данни. Колоната на кофата е избрана по такъв начин, че да има най-малък брой кардиналност.

Тези подходи не са налични в традиционния метод на SQL.

- ТИП ДАННИ

При традиционен подход поддържаният тип данни са много ограничени. Той поддържа само структурирани данни. По този начин за почистване и форматиране на самата схема на данни ще отнеме повече време. Но Hadoop поддържа сложен тип данни като Array, Struct и Map. Това насърчава използването на различни видове набор от данни, които да се използват за зареждане на данни. За Ex: XML данните могат да бъдат заредени чрез дефиниране на данните с XML елементи, съдържащи сложен тип данни.

- КОМПРЕСИРАНЕ НА ДАННИ

Съществуват много по-малко вградени техники за компресия, налични за традиционната система от бази данни. Но за рамката на Hadoop има много техники за компресия като gzib, bzip2, LZO и snappy. Режимът на компресия по подразбиране е LZ4. Дори таблиците могат да бъдат компресирани с помощта на техники за компресиране като Паркет, ORC. Техниките за компресиране помагат за правенето на таблиците да заемат много по-малко пространство увеличават пропускателната способност и по-бързото изпълнение на заявките.

Таблица за сравнение на Hadoop Vs SQL

| Характеристики | Традиционен SQL | Hadoop |

| Размер на данните | гигабайта | петабайта |

| достъп | Интерактивна & Партидна | партида |

| Актуализациите | Четене и писане - Няколко пъти | Пишете веднъж, четете няколко пъти |

| структура | Статична схема | Динамична схема |

| Интегритет | Високо | ниско |

| мащабиране | Non-Linear | линеен |

Таблица : Сравнение между традиционните Hadoop и SQL Framework.

Заключение - Hadoop Vs SQL

Като цяло, Hadoop изпреварва традиционния SQL по отношение на разходите, времето, производителността, надеждността, поддръжността и наличието на данни за много голямата потребителска група. За да се справи ефективно с огромното количество данни, генерирани всеки ден, Hadoop рамката помага за навременно заснемане, съхраняване, обработка, филтриране и накрая съхраняване в нея на централизирано място.

Препоръчителен член

- Hadoop срещу кошера - открийте най-добрите разлики

- Научете 10-те полезни разлики между Hadoop срещу Redshift

- HADOOP срещу RDBMS | Познайте 12-те полезни разлики

- Apache Hadoop срещу Apache Spark | Топ 10 сравнения, които трябва да знаете!

- Hadoop vs Spark: Характеристики