Въведение в методите за машинно обучение

Следващата статия Методи за машинно обучение предоставя очертание на най-често използваните методи в машинното обучение. Машинното обучение е техника, благодарение на която компютърът може да „научава“ нещата самостоятелно. Алгоритмите адаптивно подобряват тяхната ефективност, тъй като наличните данни за обучение се увеличават. Тоест Повече данни, толкова по-точен би бил моделът ни.

Как машините учат?

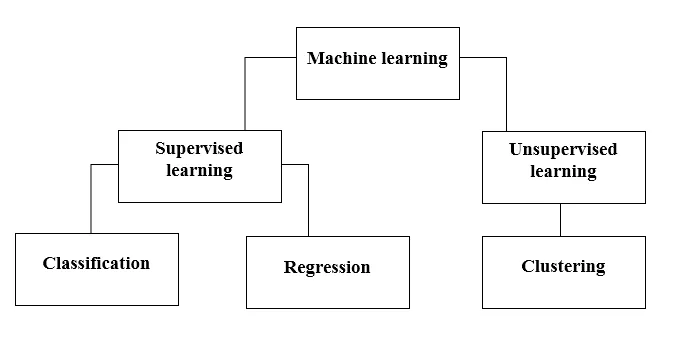

Има различни методи за това. Кой метод да следвате напълно зависи от изложението на проблема. В зависимост от набора от данни и нашия проблем има два различни начина да отидете по-дълбоко. Единият е контролирано учене, а другият е обучението без надзор. Следващата диаграма обяснява по-нататъшната класификация на методите за машинно обучение. Ще ги обсъдим един по един.

Вижте следната диаграма!

Нека да разберем какво означава надзорно обучение.

Контролирано обучение

Както подсказва името, представете си учител или ръководител, който да ви помогне да научите. Същото важи и за машините. Ние тренираме или преподаваме машината, използвайки обозначени данни.

Някои от най-готините приложения за обучение се контролират:

- Анализ на чувството (Twitter, Facebook, Netflix, YouTube и т.н.)

- Обработка на естествен език

- Класификация на изображенията

- Прогнозен анализ

- Разпознаване на шаблон

- Откриване на спам

- Реч / последователност обработка

Сега контролираното обучение е допълнително разделено на класификация и регресия. Нека да разберем това.

класификация

Класификацията е процесът на намиране на модел, който помага да се разделят данните в различни категорични класове. В този процес данните се категоризират под различни етикети според някои параметри, дадени във входа и след това етикетите се прогнозират за данните. Категорично означава променливата на изхода е категория, т.е. червено или черно, спам или не спам, диабетик или недиабетик и т.н.

Класификационните модели включват поддържаща векторна машина (SVM), K-най-близкият съсед (KNN), Naive Bayes и т.н.

а) Машинен класификатор за поддръжка (SVM)

SVM е контролиран метод на обучение, който разглежда данните и ги сортира в една от двете категории. Използвам хиперплан, за да категоризирам данните. Линеен дискриминационен класификатор се опитва да начертае права линия, разделяща двата набора от данни и по този начин да създаде модел за класификация. Той просто се опитва да намери линия или крива (в две измерения) или колектор (в множество измерения), който разделя класовете един от друг.

Забележка - За многокласната класификация SVM използва „един срещу почивка“, което означава изчисляване на различен SVM за всеки клас.

б) K-най-близък съседен класификатор (KNN)

- Ако прочетете внимателно, самото име подсказва какво прави алгоритъмът. KNN счита, че точките от данни, които са по-близо, са много по-сходни по характеристики и следователно е по-вероятно да принадлежат към същия клас като съседния. За всяка нова точка от данни се изчислява разстоянието до всички други точки от данни и класът се решава въз основа на K най-близките съседи. Да, може да звучи куцо, но за някои от класификацията работи като всичко.

- Точка от данни се класифицира според максималния брой гласове на своите съседи, след което точката от данни се присвоява на най-близкия клас сред k-съседите.

- В KNN не се изисква изучаване на модела и цялата работа се случва в момента, в който се изисква прогноза. Ето защо KNN често се нарича алгоритъм на мързеливо обучение.

в) Naive Bayes класификатор

- Naive Bayes е алгоритъм за машинно обучение, който силно се препоръчва при проблеми с класификацията на текст. Тя се основава на теоремата за вероятността на Байес. Тези класификатори се наричат наивни, защото приемат, че променливите на характеристиките са независими една от друга. Това означава, че имаме пълно изречение за въвеждане, тогава Naïve Bayes приема, че всяка дума в изречението е независима от останалите. И след това ги класифицирайте съответно. Знам, изглежда доста наивно, но е чудесен избор за проблеми с класификацията на текст и е популярен избор за класификация на спам имейл.

- Той предоставя различни видове алгоритми на наивни байеси като BernoulliNB, GaussianNB, MultinomialNB.

- Той счита всички функции за несвързани, така че не може да научи връзката между характеристиките. Например, да речем, Варун обича да яде бургери, той също обича да яде пържени картофи с кокс. Но той не обича да яде бургер и комбинация от пържени картофи с кокс заедно. Тук Naive Bayes не може да научи връзката между две характеристики, а само научава само индивидуалната значимост.

Сега да преминем към другата страна на нашия контролиран метод на обучение, който е регресия.

регресия

Регресията е процесът на намиране на модел, който помага да се диференцират данните, като се използват непрекъснати стойности. При това се подрежда естеството на прогнозираните данни. Някои от най-широко използваните регресионни модели включват Линейна регресия, Случайна гора (дървета на решения), Невронни мрежи.

Линейна регресия

- Един от най-простите подходи в контролираното обучение, който е полезен при прогнозиране на количествения отговор.

- Линейната регресия включва намиране на най-подходящата права линия през точките. Най-подходящата линия се нарича регресионна линия. Линията с най-доброто пасване не преминава точно през всички точки от данни, но вместо това се опитва, най-добре е да се доближите до тях.

- Това е широко използваният алгоритъм за непрекъснати данни. Тя обаче се фокусира само върху средната стойност на зависимата променлива и се ограничава до линейна връзка.

- Линейна регресия може да се използва за времеви серии, прогнозиране на тенденции. Може да прогнозира бъдещи продажби въз основа на предишните данни.

Неуправляемо обучение

- Ненадзорното обучение се основава на подхода, който може да се мисли като отсъствие на учител и следователно на абсолютни мерки за грешки. Полезно е, когато се изисква да научите клъстериране или групиране на елементи. Елементите могат да бъдат групирани (групирани) според тяхната прилика.

- При обучението без надзор данните се маркират, не се категоризират и алгоритмите на системата действат върху данните без предварително обучение. Неуправляемите алгоритми за обучение могат да изпълняват по-сложни задачи от контролираните алгоритми за обучение.

- Неуправляемото обучение включва клъстериране, което може да се извърши с използване на К означава клъстериране, йерархична, гауссова смес, скрит Марков модел.

Неуправляемите приложения за обучение са:

- Откриване на сходство

- Автоматично етикетиране

- Сегментиране на обекта (като лице, животно, филми)

Групирането

- Клъстеризирането е техника, която не се контролира, която се използва за анализ на данни в много области. Алгоритъмът за клъстериране е удобен, когато искаме да добием подробна информация за нашите данни.

- Пример от реалния свят за клъстериране са жанровите клъстери на Netflix, които са разделени за различни целеви клиенти, включително интереси, демографски данни, начин на живот и др. клиенти.

а) K означава клъстеризация

- K означава алгоритъмът за клъстеринг се опитва да раздели дадените неизвестни данни на клъстери. Той избира произволно 'k' клъстери центроид, изчислява разстоянието между точките от данни и центроидите на клъстери и след това накрая присвоява точката от данни на клетъчния център, чието разстояние е минимално от всички клетъчни центроиди.

- В k-означава, групите се определят от най-близкия центроид за всяка група. Този центроид действа като "мозък" на алгоритъма, те придобиват точките от данни, които са най-близо до тях и след това ги добавят към клъстерите.

б) Йерархична клъстеризация

Йерархичното клъстериране е почти подобно на това при нормалното клъстериране, освен ако не искате да изградите йерархия на клъстери. Това може да ви е полезно, когато искате да решите броя на клъстерите. Да предположим, че създавате групи от различни артикули в онлайн магазина за хранителни стоки. На предната начална страница искате няколко широки елемента и след като щракнете върху един от елементите, се отварят конкретни категории, тоест по-специфични клъстери.

Намаляване на размерите

Намаляването на размерите може да се счита за компресия на файл. Това означава изваждане на информацията, която не е релевантна. Намалява сложността на данните и се опитва да запази значимите данни. Например при компресиране на изображението намаляваме размерите на пространството, в което изображението остава такова, каквото е, без да унищожаваме твърде много от съдържателното съдържание в изображението.

PCA за визуализация на данни

Анализът на основните компоненти (PCA) е метод за намаляване на размерите, който може да бъде полезен за визуализиране на вашите данни. PCA се използва за компресиране на по-високомерни данни към по-нискомерни данни, тоест можем да използваме PCA за намаляване на четиримерни данни в три или 2 измерения, така че да можем да визуализираме и да получим по-добро разбиране на данните.

Препоръчителни статии

Това е ръководство за методи за машинно обучение. Тук сме обсъдили въведение, как машините учат? класификации на машинно обучение и блок-схема заедно с подробно обяснение. Можете да разгледате и другите ни предложени статии, за да научите повече -

- Архитектура на машинно обучение

- Рамки за машинно обучение

- Инструменти за машинно обучение

- Техники за машинно обучение

- Хиперпараметрово машинно обучение

- Йерархичен алгоритъм на клъстериране

- Йерархично клъстериране | Агломеративно и разделно клъстеризиране