Разлика между Apache Storm и Apache Spark

Apache Storm е отворен код, мащабируем, устойчив на повреди и разпределена система за изчисляване в реално време. Apache Storm е фокусирана върху поточната обработка или обработката на събития. Apache Storm прилага отказоустойчив метод за извършване на изчисление или тръбопровод на множество изчисления на събитие, докато се влива в система. Apache Spark е светкавична и клъстерна изчислителна технологична рамка, предназначена за бързи изчисления при мащабна обработка на данни. Apache Spark е двигател с разпределена обработка, но не се предлага с вграден клъстер за управление на ресурси и разпределена система за съхранение. Трябва да включите мениджър на клъстери и система за съхранение по ваш избор.

Представяме ви повече за Apache Storm срещу Apache Spark:

- Apache Storm е паралелен на задачите непрекъснат изчислителен двигател. Той определя работните си процеси в насочени ациклични графики (DAG's), наречени топологии. Тези топологии се изпълняват, докато не бъдат изключени от потребителя или срещнат невъзстановим отказ. Apache Storm не работи на клъстери Hadoop, но използва Zookeeper и собствения си работник-миньон, за да управлява своите процеси. Apache Storm може да чете и записва файлове в HDFS.

- Apache Storm се интегрира с опашките и технологиите за бази данни, които вече използвате. Буря топология консумира потоци от данни и обработва тези потоци по произволно сложни начини, преразпределяйки потоците между всеки етап от изчислението, колкото е необходимо. Apache Storm се основава на кортежи и потоци. Една настройка е основно това, което са вашите данни и как са структурирани.

- Рамката Apache Spark се състои от Spark Core и набор от библиотеки. Spark core изпълнява и управлява нашата работа, като предоставя безпроблемно изживяване на крайния потребител. Потребителят трябва да изпрати задача на Spark core, а Spark core се грижи за по-нататъшна обработка, изпълнение и отговор на потребителя. Имаме Spark Core API на различни скриптови езици като Scala, Python, Java и R.

- В Apache Spark потребителят може да използва Apache Storm за преобразуване на неструктурирани данни, докато те се влеят в желания формат. Трябва да включите мениджър на клъстери и система за съхранение по ваш избор.

- Можете да изберете Apache YARN или Mesos за мениджъра на клъстери за Apache Spark.

- Можете да изберете Hadoop разпределена файлова система (HDFS), облачно хранилище в Google, Amazon S3, Microsoft Azure за мениджър на ресурси за Apache Spark.

- Apache Spark е двигател за обработка на данни за пакетни и поточни режими, включващ SQL заявки, обработка на графики и машинно обучение.

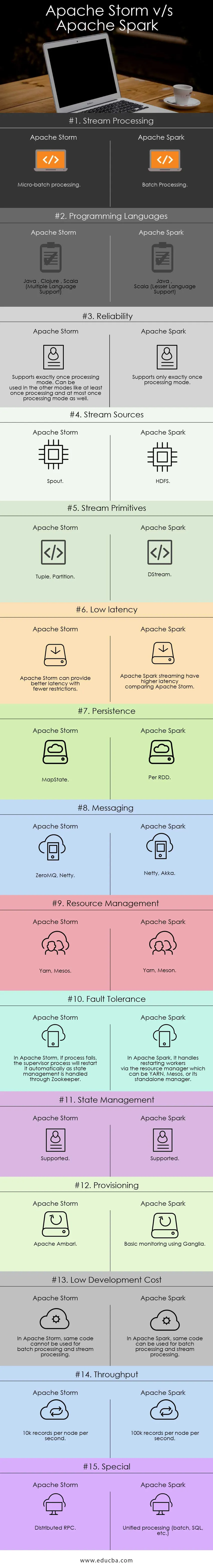

Сравнение между главата на Apache Storm и Apache Spark (Инфографика):

Ключови разлики между Apache Storm срещу Apache Spark:

По-долу са списъците с точки, опишете ключовите разлики между Apache Storm и Apache Spark:

- Apache Storm извършва изчисления с паралелни задачи, докато Apache Spark извършва изчисления с паралелни данни.

- Ако възелът на работника се провали в Apache Storm, Nimbus възлага задачата на работниците на другия възел и всички кортежи, изпратени на неуспешен възел, ще бъдат изтичани и следователно автоматично възпроизведени, докато в Apache Spark, ако работният възел се провали, системата може да се изчисли повторно от остатъчно копие на входни данни и данни може да се загуби, ако данните не се репликират.

- Гаранцията за доставка на Apache Strom зависи от сигурен източник на данни, докато в Apache Spark HDFS източникът на данни е безопасен.

- Apache Storm е машина за обработка на потоци за обработка на поточни данни в реално време, докато Apache Spark е изчислителна машина с общо предназначение.

Характеристики на Apache Storm:

- Толерантност на грешките - при отпадане на работните нишки или възел се спуска, работниците автоматично се рестартират

- Мащабируемост - силно мащабируема, Storm може да поддържа производителността дори при увеличаване на натоварването, като добавя ресурси линейно, където може да се постигне скорост на пропускане от дори един милион 100 байтови съобщения в секунда на възел

- Закъснение - Storm извършва опресняване на данните и отговор от край до край за секунди или минути зависи от проблема. Има много ниска латентност.

- Лесна употреба при разгръщане и работа на системата.

- Интегриран с Hadoop за използване на по-висока производителност

- Лесен за изпълнение и може да бъде интегриран с всеки език за програмиране

- Apache Storm е отворен код, здрав и лесен за използване. Може да се използва в малки компании, както и в големи корпорации

- Позволява обработка на потоци в реално време с невероятно бързо, защото и има огромна сила за обработка на данните.

- Apache Storm има оперативно разузнаване.

- Apache Storm осигурява гарантирана обработка на данни, дори ако някой от свързаните възли в клъстера умре или съобщенията са загубени

Характеристики на Apache Spark:

- Скорост: Apache Spark помага да стартирате приложение в клъстер Hadoop, до 100 пъти по-бърз в паметта и 10 пъти по-бърз при работа на диск.

- Обработка в реално време: Искрата Apache може да обработва поточни данни в реално време.

- Използваемост : Apache Spark има възможност да поддържа множество езици като Java, Scala, Python и R

- Мързелива оценка: В Apache Spark трансформациите са мързеливи по природа. Той ще даде резултат след формиране на ново RDD от съществуващото.

- Интеграция с Hadoop: Apache Spark може да работи независимо, а също и на Hadoop YARN Cluster Manager и по този начин може да чете съществуващи данни на Hadoop.

- Толерантност на повредите : Apache Spark осигурява толерантност на грешки, използвайки RDD концепция. Искровите RDD устройства са проектирани да се справят с отказа на всеки работен възел в клъстера.

Apache Storm срещу Apache Spark Таблица за сравнение

Обсъждам основни артефакти и разграничавам Apache Storm от Apache Spark.

| Apache Storm | Apache Spark | |

| Обработка на потоци | Микро-партидна обработка | Партидна обработка |

| Програмни езици | Java, Clojure, Scala (поддръжка на няколко езика) | Java, Scala (по-малка езикова поддръжка) |

| надеждност | Поддържа точно веднъж режим на обработка. Може да се използва и в други режими, като поне веднъж обработка и най-много веднъж режим на обработка | Поддържа само точно веднъж режим на обработка |

| Източници на потока | чучур | HDFS |

| Поточни примати | Tuple, дял | DStream |

| Ниска латентност | Apache Storm може да осигури по-добра латентност с по-малко ограничения | Apache Spark потоците имат по-висока латентност в сравнение с Apache Storm |

| упоритост | MapState | На RDD |

| Съобщения | ZeroMQ, Netty | Нети, Акка |

| Управление на ресурси | Прежда, Месо | Прежда, Мезон |

| Толерантност на грешки | В Apache Storm, ако процесът се провали, процесът на надзора ще го рестартира автоматично, тъй като управлението на държавата се обработва чрез Zookeeper | В Apache Spark, той обработва рестартиращи работници чрез мениджъра на ресурси, който може да бъде YARN, Mesos или неговия самостоятелен мениджър |

| Управление на държавата | Поддържани | Поддържани |

| Provisioning | Apache Ambari | Основен мониторинг с помощта на Ganglia |

| Ниска цена за развитие | В Apache Storm същият код не може да се използва за пакетна обработка и обработка на потоци | В Apache Spark същият код може да се използва за пакетна обработка и поточна обработка |

| магистрала | 10k записи на възел в секунда | 100k записи на възел в секунда |

| Специален | Разпределен RPC | Унифицирана обработка (пакетна, SQL и т.н.) |

Извод - Apache Storm срещу Apache Spark:

Apache Storm и Apache Spark са страхотни решения, които решават проблема с поглъщането на потоци и трансформацията. Apache Storm и Apache Spark могат да бъдат част от клъстер Hadoop за обработка на данни. Apache Storm е решение за обработка на потоци в реално време. Но Storm е много сложен за разработчиците да разработват приложения поради ограничени ресурси.

Apache Storm най-вече може да се използва за обработка на потоци. Но индустрията се нуждае от общо решение, което може да реши всички видове проблеми. Например пакетна обработка, интерактивна обработка на потоци, както и итеративна обработка. И така, Apache Spark влиза в светлината на прожекторите, която е двигател за изчисление с общо предназначение. Това е причината търсенето на Apache Spark да сравнява повече други инструменти от ИТ специалистите. Apache Spark може да се справи с различни видове проблеми. Отделно от това Apache Spark е твърде лесно за разработчиците и може да се интегрира много добре с Hadoop. Apache Spark ви дава гъвкавост за работа на различни езици и среда.

Препоръчителен член

Това е ръководство за Apache Storm срещу Apache Spark, тяхното значение, сравнение между главата, ключови разлики, таблица за сравнение и заключение. Можете също да разгледате следните статии, за да научите повече -

- Iaas vs Azure Pass - разлики, които трябва да знаете

- Apache Hadoop срещу Apache Spark | Топ 10 сравнения, които трябва да знаете!

- 7 невероятни наръчника за Apache Spark (Ръководство)

- Най-добрите 15 неща, които трябва да знаете за MapReduce срещу Spark

- Hadoop vs Apache Spark - интересни неща, които трябва да знаете