Въведение в простата линейна регресия

От речника : завръщане към предишно или по-малко развито състояние.

В статистиката: Мярка за връзката между средната стойност на една променлива и съответните стойности на другите променливи.

Регресията, при която връзката между входната променлива (независима променлива) и целева променлива (зависима променлива) се счита за линейна, се нарича Линейна регресия. Простата линейна регресия е вид линейна регресия, при която имаме само една независима променлива, за да прогнозираме зависимата променлива. Простата линейна регресия е един от алгоритмите за машинно обучение. Простата линейна регресия принадлежи към семейството на контролираното обучение. Регресията се използва за прогнозиране на непрекъснати стойности.

Модел на проста линейна регресия

Нека го направим просто. Как започна всичко?

Всичко започва през 1800 г. с Франсис Галтън. Той изучи връзката във височината между бащите и техните синове. Той наблюдава модел: или височината на сина ще бъде толкова висока, колкото височината на баща му или височината на сина ще бъде по-близка до общата средна височина на всички хора. Това явление не е нищо друго освен регресия.

Например, Shaq O'Neal е много известен NBA играч и е висок 2, 16 метра. Синовете му Шакир и Шариф О'неал са съответно 1, 96 метра и 2, 06 метра. Средната височина на населението е 1, 76 метра. Регрес на височината на сина (дрейф към) средната височина.

Как правим регресия?

Изчисляване на регресия само с две точки от данни:

Всичко, което искаме да направим, за да намерим най-добрата регресия, е да начертаем линия, която е възможно най-близка до всяка точка. В случай на две точки от данни е лесно да нарисувате линия, просто се присъединете към тях.

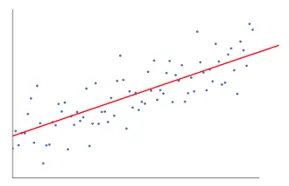

Сега, ако имаме няколко точки от данни сега, как да нарисуваме линията, която е възможно най-близка до всяка точка от данни.

В този случай нашата цел е да сведем до минимум вертикалното разстояние между линията и всички точки от данни. По този начин прогнозираме най-добрата линия за нашия линеен регресионен модел.

Какво прави обикновената линейна регресия?

По-долу е дадено подробно обяснение на Simple Linear Regression:

- Тя очертава много и много възможни линии от линии и след това прави някой от този анализ.

- Сума от квадратни грешки.

- Сума от абсолютни грешки.

- метод на най-малко квадрат … и т.н.

- За нашия анализ ще използваме метода на най-малко квадрат.

- Ще направим разлика на всички точки и ще изчислим квадрата от сбора на всички точки. Който и ред да даде минималната сума, ще бъде най-добрият ни ред.

Например: По този начин бихме могли да вземем множество мъже и ръста на техния син и да направим неща като да кажем на човек колко висок може да бъде синът му. преди дори да се е родил.

Гугъл изображение

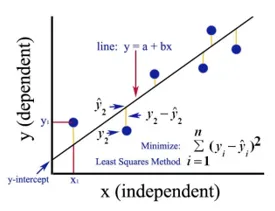

Горната фигура показва проста линейна регресия. Линията представлява регресионната линия. Дадено от: y = a + b * x

Където y е зависимата променлива (DV): Например, как се променя заплатата на дадено лице в зависимост от броя години опит, който служителят има. Така че тук заплатата на служител или човек ще бъде вашата зависима променлива.

Зависимата променлива е нашата целева променлива, тази, която искаме да предвидим, използвайки линейна регресия.

x е нашата независима променлива (IV): Зависимата променлива е причината за промяната независима променлива. В горния пример броят години опит е нашата зависима променлива, тъй като броят на годините опит причинява промяната в заплатата на служителя.

- b е коефициентната променлива за нашата независима променлива x. Този коефициент играе решаваща роля. Той казва как промяната на единица в x (IV) ще се отрази на y (DV). Той също се нарича коефициент на пропорционалност. По отношение на математиката, зависи от вас е наклонът на линията или можете да кажете стръмен от линията.

- В нашия пример, ако наклонът (б) е по-малък, което означава, че броят на годините ще доведе до по-малко увеличение на заплатата, от друга страна, ако наклонът (б) е по-голям ще доведе до високо увеличение на заплатата с увеличаване на броя на Години опит.

- a е постоянна стойност. Той се нарича също прехващане, където линията пресича y-оста или DV-оста. По друг начин можем да кажем, когато служителят има нулев опит (x), тогава заплатата (y) за този служител ще бъде постоянна (a).

Как работи Least Square?

По-долу са точките за най-малко квадратни работи:

- Тя очертава произволна линия според тенденциите на данните.

- Той взема точки от данни и очертава вертикални линии. Той счита вертикалното разстояние като параметър.

- Тези вертикални линии ще прережат регресионната линия и ще дадат съответната точка за точките от данни.

- След това ще намери вертикалната разлика между всяка точка от данни и съответната й точка от данни на регресионната линия.

- Той ще изчисли грешката, която е квадратна от разликата.

- След това изчислява сумата от грешки.

- След това отново ще начертае линия и ще повтори горната процедура още веднъж.

- Тя рисува редица линии по този начин и линията, която дава най-малко сума на грешка, е избрана за най-добрата линия.

- Тази най-добра линия е нашата проста линейна регресионна линия.

Прилагане на проста линейна регресия

Регресионен анализ се извършва за прогнозиране на непрекъснатата променлива. Регресионният анализ има голямо разнообразие от приложения. Някои примери са следните:

- Предсказуем анализ

- Ефективност на маркетинга,

- ценообразуване на всяка обява

- промоция прогноза за даден продукт.

Тук ще обсъдим едно приложение на линейна регресия за прогнозна анализа. Ще правим моделиране, използвайки python.

Стъпките, които ще следваме, за да изградим нашия модел са следните:

- Ще импортираме библиотеките и наборите от данни.

- Предварително ще обработим данните.

- Ще разделим данните на тестовия и обучителния набор.

- Ще създадем модел, който ще се опита да предвиди целевата променлива въз основа на нашия набор от тренировки

- Ще предвидим целевата променлива за тестовия набор.

- Ще анализираме резултатите, предвидени от модела

За нашия анализ ще използваме набор от данни за заплатите с данни за 30 служители.

# Импортиране на библиотеки

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

# Импортиране на набора от данни (Проба от данни е показана в таблицата)

dataset = pd.read_csv('Salary_Data.csv')

| Години опит | Заплата |

| 1.5 | тридесет и седем хиляди седемстотин тридесет и една |

| 1.1 | 39343 |

| 2.2 | 39891 |

| 2 | 43525 |

| 1.3 | 46205 |

| 3.2 | 54445 |

| 4 | 55749 |

# Предварителна обработка на набора от данни, тук ще разделим набора от данни на зависима и независима променлива. x като независим и y като зависима или целева променлива

X = dataset.iloc(:, :-1).values

y = dataset.iloc(:, 1).values

# Разделяне на набора от данни в набор за обучение и тест:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size = 1/3, random_state = 0)

Тук тест размер 1/3 показва, че от общите данни 2/3 част е за обучение на модела, а останалата част 1/3 се използва за тестване на модела.

# Нека приспособим модела на нашата проста линейна регресия към обучителния комплект

from sklearn.linear_model import LinearRegression

regressor = LinearRegression()

regressor.fit(X_train, y_train)

Моделът на линейна регресия се обучава сега. Този модел ще се използва за прогнозиране на зависимата променлива.

# Предсказване на резултатите от тестовия набор

y_pred = regressor.predict(X_test)

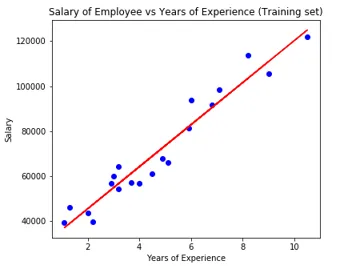

# Визуализиране на резултатите от тестовия набор

plt.scatter(X_test, y_test, color = 'blue')

plt.plot(X_train, regressor.predict(X_train), color = 'red')

plt.title('Salary of Employee vs Experience (Test set)')

plt.xlabel('Years of Experience')

plt.ylabel('Salary')

plt.show()

# Параметър на модела

print(regressor.intercept_)

print(regressor.coef_)

26816.19224403119

(9345.94244312)

Така че стойността на прихващащия (а) е 26816. Което предполага, че всеки по-свеж (нулев опит) би получил около 26816 сума като заплата.

Коефициентът за нашия модел излезе като 9345.94. Той предполага, че поддържайки всички останали параметри постоянни, промяната в една единица от независимата променлива (години на годност) ще доведе до промяна на 9345 единици в заплатата.

Показатели за оценка на регресията

На практика има три важни метода за оценка на регресията:

- Средна абсолютна грешка (MAE): Тя показва средната стойност на абсолютните грешки, която е разликата между прогнозираната и действителната.

- Средна квадратна грешка (MSE): Тя показва средната стойност на квадратните грешки.

- Root Mean Squared Error (RMSE): Показва квадратния корен на средната стойност на грешките в квадрат.

Можем да сравним горните тези методи:

- MAE: Показва средната грешка и най-лесният от трите метода.

- MSE: Този е по-популярен от MAE, защото увеличава по-големите грешки, което в резултат показва повече прозрения.

- RMSE: Този е по-добър от MSE, защото можем да интерпретираме грешката по отношение на y.

Тези 3 са нищо друго освен функциите за загуба.

# Оценка на модела

from sklearn import metrics

print('MAE:', metrics.mean_absolute_error(y_test, y_pred))

print('MSE:', metrics.mean_squared_error(y_test, y_pred))

print('RMSE:', np.sqrt(metrics.mean_squared_error(y_test, y_pred)))

MAE: 3426.4269374307123

MSE: 21026037.329511296

RMSE: 4585.4157204675885

заключение

Линейният регресионен анализ е мощен инструмент за алгоритми за машинно обучение, който се използва за прогнозиране на непрекъснати променливи като заплата, продажби, производителност и др. Линейната регресия разглежда линейната връзка между независими и зависими променливи. Простата линейна регресия има само една независима променлива, въз основа на която моделът прогнозира целевата променлива. Обсъдихме модела и прилагането на линейна регресия с пример за прогнозен анализ за прогнозиране на заплатата на служителите.

Препоръчителни статии

Това е ръководство за проста линейна регресия. Тук обсъждаме модела и прилагането на линейна регресия, като използваме пример за прогнозен анализ за прогнозиране на заплатите на служителите. Можете също да разгледате и другите ни свързани статии, за да научите повече-

- Линеен регресионен анализ

- Линейна регресия в R

- Линейно регресионно моделиране

- Инструменти за тестване на регресия

- Matplotlib In Python | Топ 14 парцела в Matplotlib

- Речник на Python | Методи и примери

- Примери за квадратен корен в PHP

- Линейна регресия срещу логистична регресия | Топ разлики