Въведение в методите на ядрото в машинното обучение

Алгоритъмът, използван за анализ на модели, се нарича метод на ядрото в машинното обучение. По принцип се прави анализ, за да се намерят отношенията в наборите от данни. Тези отношения могат да бъдат клъстериране, класификация, основни компоненти, корелация и др. Повечето от тези алгоритми, които решават тези задачи за анализиране на модела, Нуждаят се от данни в суров представител, за да бъдат изрично трансформирани в представяне на характеристика вектор. Тази трансформация може да се извърши чрез определена от потребителя карта с функции. Така че може да се приеме, че методът на ядрото се изисква само посочено от потребителя ядро.

Терминологичният метод на Kernal идва от факта, че те използват функцията на ядрото, което им позволява да извършват операцията във високомерно, имплицитно пространство от функции, без да е необходимо да изчисляват координатите на данните в това пространство. Вместо това те просто изчисляват вътрешния продукт между изображенията на всички двойки данни в пространството с функции.

Тези видове операции са изчислително по-евтини през повечето време в сравнение с изричното изчисляване на координатите. Тази техника се нарича „трик на ядрото“. Всеки линеен модел може да бъде преобразуван в нелинеен модел чрез прилагане на трика на ядрото към модела.

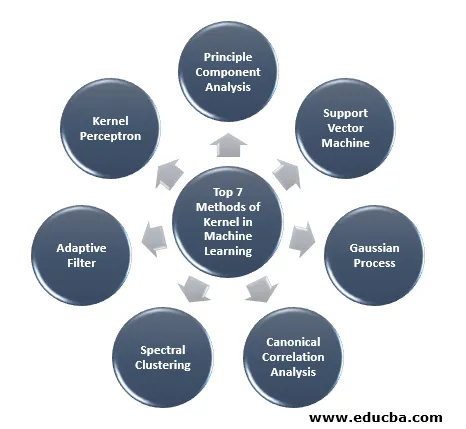

Методът на ядрото, наличен в машинното обучение, е анализ на основните компоненти (PCA), спектрално групиране, машини за поддържащ вектор (SVM), каноничен корелационен анализ, перцептрон на ядрото, гаусски процеси, регрес на гребена, линейни адаптивни филтри и много други. Нека да разберем на високо ниво няколко от тези методи на ядрото.

Топ 7 методи на ядрото в машинното обучение

Ето методите на ядрото в машинното обучение споменаваме по-долу:

1. Анализ на принциповите компоненти

Анализът на основните компоненти (PCA) е техника за извличане на структура от евентуално големи масиви от данни. Той лесно се изпълнява с помощта на итеративни алгоритми, които оценяват основните компоненти или чрез решаване на проблем със собствено значение. PCA е ортогонална трансформация на координатната система, в която описваме нашите данни. Новата координатна система се получава чрез проекция върху основните оси на данните. Малък брой основни компоненти често са достатъчни, за да отчитат по-голямата част от структурата в данните. Едно от основните му приложения е да се извърши проучвателен анализ на данни за изготвяне на прогнозен модел. Използва се предимно за визуализиране на свързаността между популациите и генетичното разстояние.

2. Подкрепа Векторна машина

SVM може да бъде определен като класификатор за разделяне на хиперплана, където хиперпланът е подпространството с едно измерение, по-малко от околното пространство. Размерът на това математическо пространство се определя като минимален брой координати, необходими за уточняване на всяка точка, докато околното пространство е пространството, което заобикаля математическия обект. Сега Математическият обект може да бъде разбран като абстрактен обект, който не съществува по всяко време или място, но съществува като вид нещо.

3. Гаусски процес

Гаусският процес е кръстен на Карк Фридрих Гаус, тъй като използва обозначението на Гаусово разпределение (нормално разпределение). Това е стохастичен процес, който означава съвкупност от случайни променливи, индексирани по време или пространство. В Гауссов процес случайните променливи имат многовариантно нормално разпределение, т.е. всички крайни линейни комбинации от него са нормално разпределени. Гаусският процес използва свойствата, наследени от нормално разпределение и затова са полезни при статистическо моделиране. Алгоритъмът за машинно обучение, който включва този метод на ядрото, използва мярката за мързеливо обучение и сходството между точките, за да прогнозира стойността на невижданите точки от данните за обучение. Това прогнозиране е не само оценката, но и несигурността в този момент.

4. Каноничен анализ на корелацията

Каноничният анализ на корелацията е начин за извеждане на информация от кръстосани ковариационни матрици. Известен е и като анализ на канонични променливи. Да предположим, че имаме два вектора X, Y на случайна променлива, казват два вектора X = (X1, …, Xn) и вектор Y = (Y1, …, Ym), и променливата, имаща корелация, тогава CCA ще изчисли линейна комбинация от X и Y, който има макс корелация помежду си.

5. Спектрална клъстеризация

При прилагането на сегментация на изображението, спектралното клъстериране е известно като категоризация на обекти на базата на сегментиране. В спектралното клъстериране намаляването на размерността се извършва преди клъстерирането в по-малко измерение, това става чрез използване на собственото значение на матрицата за сходство на данните. Той има своите корени в теорията на графовете, където този подход се използва за идентифициране на общности от възли в графика, която се основава на ръбовете, които ги свързват. Този метод е достатъчно гъвкав и ни позволява да групираме данни и от не-графика.

6. Адаптивен филтър

Адаптивният филтър използва линеен филтър, който включва функция за прехвърляне, която се контролира от променливи параметри и методи, които ще бъдат използвани за настройване на тези параметри според алгоритъма за оптимизация. Сложността на този алгоритъм за оптимизация е причината, че целият адаптивен филтър е цифров филтър. Необходим е адаптивен филтър в тези приложения, където няма предварителна информация за желаната операция на обработка или те се променят.

Функцията за разходи се използва в адаптивния филтър за затворен контур, тъй като е необходима за оптималната работа на филтъра. Той определя как да промените функцията за прехвърляне на филтър, за да намалите цената на следващата итерация. Една от най-често срещаните функции е средната квадратна грешка на сигнала за грешка.

7. Ядро Перцептрон

При машинното обучение ядрото на рецептор е вид на популярния алгоритъм за учене на персептрон, който може да научи машините на ядрото, като например нелинейни класификатори, които използват функция на ядрото, за да изчислят приликата на онези проби, които не са видени на обучителни проби. Този алгоритъм е изобретен през 1964 г., което го прави първият ученик по класификация на ядрото.

Повечето от обсъжданите алгоритми на ядрото се основават на изпъкнала оптимизация или собствени проблеми и са статистически добре обосновани. Техните статистически свойства се анализират с помощта на статистическата теория за обучение.

Говорейки за областите на приложение на методите на ядрото, той е разнообразен и включва геостатистика, кригинг, инверсивно претегляне, 3D реконструкция, биоинформатика, химиоинформатика, извличане на информация и разпознаване на почерк.

заключение

Обобщих някои от терминологиите и видовете методи на ядрото в машинното обучение. Поради липса на място тази статия в никакъв случай не е изчерпателна и е предназначена само да ви даде разбиране за това какво представлява методът на ядрото и кратко резюме на техните типове. Въпреки това, покриването на тази статия ще ви накара да направите първата стъпка в областта на машинното обучение.

Препоръчителни статии

Това е ръководство за метода на ядрото в машинното обучение. Тук обсъждаме 7 вида методи на ядрото в машинното обучение. Можете също да разгледате следната статия.

- Монолитно ядро

- Клъстеризиране в машинно обучение

- Машинно обучение за наука на данни

- Неподдържано машинно обучение

- PHP филтри | Как да потвърдите въвеждането на потребител с различни филтри?

- Пълно ръководство за жизнения цикъл на машинното обучение