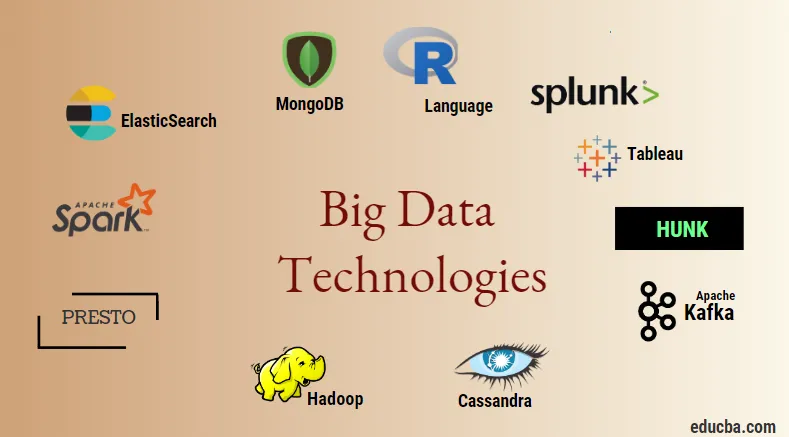

Въведение в големите технологии за данни

Технологията за големи данни и Hadoop е голяма модна дума, както може да звучи. Тъй като има голям ръст в областта на данните и информацията от всяка индустрия и домейн, става много важно да се създаде и въведе ефективна техника, която да се грижи за всички нужди и изисквания на клиентите и големите индустрии, които са отговорни за генерирането на данни, По-рано данните се обработваха от нормални езици за програмиране и прост структуриран език на заявките, но сега тези системи и инструменти изглежда не правят много в случай на големи данни. Технологията за големи данни се определя като технология и софтуерна програма, която е предназначена за анализ, обработка и извличане на информация от голям набор от изключително сложна структура и големи масиви от данни, което е много трудно за традиционните системи да се справят. Технологията за големи данни се използва за обработка както на данни в реално време, така и на партиди. Машинното обучение се превърна в много критичен компонент от ежедневието и всяка индустрия и следователно управлението на данните чрез големи данни става много важно.

Видове технологии за големи данни

Преди да започнем със списъка на технологиите, нека първо да видим широката класификация на всички тези технологии. Те могат да бъдат класифицирани главно в 4 домена.

- Хранилище за данни

- анализ

- Извличане на данни

- Визуализацията

Нека първо покрием всички технологии, които попадат под чадъра за съхранение.

1. Hadoop : Когато става въпрос за големи данни, Hadoop е първата технология, която влиза в игра. Това се основава на архитектура за намаляване на карти и помага при обработката на свързани с партиди задачи и обработка на информацията за партиди. Той е предназначен за съхранение и обработка на данни в разпределена среда за обработка на данни, заедно със стоков хардуер и прост модел за изпълнение на програмирането. Може да се използва за съхранение и анализ на данните, налични в различни различни машини с висока памет, скорост и ниски разходи. Това представлява един от основните компоненти на технологията за големи данни, който е разработен от софтуерната фондация Apache през 2011 г. и е написан на Java.

1. Hadoop : Когато става въпрос за големи данни, Hadoop е първата технология, която влиза в игра. Това се основава на архитектура за намаляване на карти и помага при обработката на свързани с партиди задачи и обработка на информацията за партиди. Той е предназначен за съхранение и обработка на данни в разпределена среда за обработка на данни, заедно със стоков хардуер и прост модел за изпълнение на програмирането. Може да се използва за съхранение и анализ на данните, налични в различни различни машини с висока памет, скорост и ниски разходи. Това представлява един от основните компоненти на технологията за големи данни, който е разработен от софтуерната фондация Apache през 2011 г. и е написан на Java.

2. MongoDB : Друг много съществен и основен компонент на технологията за големи данни по отношение на съхранението е базата данни MongoDB NoSQL. Това е база данни на NoSQL, което означава, че релационните свойства и другите свързани с RDBMS свойства не се прилагат към нея. Тя е различна от традиционните бази данни RDBMS, която използва структуриран език на заявките. Той използва схематични документи и структурата на съхранението на данни също е различна и следователно те са полезни за съхраняване на голям обем данни. Това е програма, проектирана и базирана на база данни, ориентирана към различни платформи, която използва документи като JSON, заедно със схема. Това се превръща в много полезен случай на използване на оперативни хранилища на данни в повечето финансови институции и по този начин работи за замяна на традиционните мейнфрейми. MongoDB управлява гъвкавостта, а също и голямо разнообразие от типове данни при големи обеми и сред разпределени архитектури.

2. MongoDB : Друг много съществен и основен компонент на технологията за големи данни по отношение на съхранението е базата данни MongoDB NoSQL. Това е база данни на NoSQL, което означава, че релационните свойства и другите свързани с RDBMS свойства не се прилагат към нея. Тя е различна от традиционните бази данни RDBMS, която използва структуриран език на заявките. Той използва схематични документи и структурата на съхранението на данни също е различна и следователно те са полезни за съхраняване на голям обем данни. Това е програма, проектирана и базирана на база данни, ориентирана към различни платформи, която използва документи като JSON, заедно със схема. Това се превръща в много полезен случай на използване на оперативни хранилища на данни в повечето финансови институции и по този начин работи за замяна на традиционните мейнфрейми. MongoDB управлява гъвкавостта, а също и голямо разнообразие от типове данни при големи обеми и сред разпределени архитектури.

3. Hunk : Полезно е за достъп до данни чрез отдалечени клъстери Hadoop чрез използване на виртуални индекси, а също така използва и езика за обработка на Splunk за търсене, който може да се използва за анализ на данни. Хункът може да се използва за отчитане и визуализиране на огромни количества данни от базите данни и източниците на Hadoop и NoSQL. Той е разработен от екип Splunk през 2013 г., който е написан на Java.

3. Hunk : Полезно е за достъп до данни чрез отдалечени клъстери Hadoop чрез използване на виртуални индекси, а също така използва и езика за обработка на Splunk за търсене, който може да се използва за анализ на данни. Хункът може да се използва за отчитане и визуализиране на огромни количества данни от базите данни и източниците на Hadoop и NoSQL. Той е разработен от екип Splunk през 2013 г., който е написан на Java.

4. Касандра : Касандра формира топ избор сред списъка с популярни бази данни NoSQL, който е безплатна и отворена база данни, която се разпространява и има широко колонно хранилище и може ефективно да обработва данни на големи стокови клъстери, т.е. тя се използва за осигуряват висока наличност заедно с нито една точка на повреда. Сред списъка с основни характеристики се включват тези като разпределена природа, мащабируемост, механизъм за устойчивост на откази, поддръжка на MapReduce, настройваща се последователност, свойство на езика на заявките, поддържа мултиплициране на репликация в центъра за данни и евентуална последователност.

4. Касандра : Касандра формира топ избор сред списъка с популярни бази данни NoSQL, който е безплатна и отворена база данни, която се разпространява и има широко колонно хранилище и може ефективно да обработва данни на големи стокови клъстери, т.е. тя се използва за осигуряват висока наличност заедно с нито една точка на повреда. Сред списъка с основни характеристики се включват тези като разпределена природа, мащабируемост, механизъм за устойчивост на откази, поддръжка на MapReduce, настройваща се последователност, свойство на езика на заявките, поддържа мултиплициране на репликация в центъра за данни и евентуална последователност.

След това ни позволява да говорим за различните области на технологията за големи данни, т.е. Data Mining.

5. Presto : Това е популярен механизъм за разпределени заявки с отворен код и базиран на SQL, който се използва за изпълнение на интерактивни заявки срещу източници на данни от всякакъв мащаб и размерите варират от Gigabytes до Petabytes. С негова помощ можем да запитваме данни в Cassandra, Hive, собствени магазини за данни и релационни системи за съхранение на бази данни. Това е машина за заявки на базата на Java, която е разработена от фондацията Apache през 2013 г. Няколко групи компании, които използват добре инструмента Presto са Netflix, Airbnb, Checkr, Repro и facebook.

5. Presto : Това е популярен механизъм за разпределени заявки с отворен код и базиран на SQL, който се използва за изпълнение на интерактивни заявки срещу източници на данни от всякакъв мащаб и размерите варират от Gigabytes до Petabytes. С негова помощ можем да запитваме данни в Cassandra, Hive, собствени магазини за данни и релационни системи за съхранение на бази данни. Това е машина за заявки на базата на Java, която е разработена от фондацията Apache през 2013 г. Няколко групи компании, които използват добре инструмента Presto са Netflix, Airbnb, Checkr, Repro и facebook.

6. ElasticSearch : Това е много важен инструмент днес, когато става дума за търсене. Това представлява основен компонент на стека ELK, т.е. еластичното търсене, Logstash и Kibana. ElasticSearch е търсачка, базирана на лучена библиотека, подобна на Solr и се използва за предоставяне на чисто разпространена, пълнотекстова търсачка, която е с възможност за мулти-наемател. Разполага със списък на JSON документи без схеми и HTTP уеб интерфейс. Тя е написана на езика JAVA и е разработена от компанията Elastic в компанията 2012. Имената на няколко компании, които използват еластични проучвания, са: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture и др.

6. ElasticSearch : Това е много важен инструмент днес, когато става дума за търсене. Това представлява основен компонент на стека ELK, т.е. еластичното търсене, Logstash и Kibana. ElasticSearch е търсачка, базирана на лучена библиотека, подобна на Solr и се използва за предоставяне на чисто разпространена, пълнотекстова търсачка, която е с възможност за мулти-наемател. Разполага със списък на JSON документи без схеми и HTTP уеб интерфейс. Тя е написана на езика JAVA и е разработена от компанията Elastic в компанията 2012. Имената на няколко компании, които използват еластични проучвания, са: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture и др.

Сега нека прочетем за всички онези големи технологии за данни, които са част от анализа на данните:

7. Apache Kafka : Известна със своята публикация-абониране или pub-sub, както е популярно известна като, е система за брокери с асинхронни съобщения за директни съобщения, която се използва за поглъщане и извършване на обработка на данни в поточно предаване на данни в реално време. Той също така предвижда период на запазване и данните могат да бъдат канализирани чрез механизъм производител-потребител. Това е една от най-популярните стрийминг платформи, която е много подобна на корпоративната система за съобщения или опашката за съобщения. Kafka стартира много подобрения до този момент и един основен вид е този на Kafka confluent, който осигурява допълнително ниво на свойства на Kafka, като Registry Schema, Ktables, KSql и др. Той е разработен от общността на Apache Software през 2011 г. и е написано на Java. Компаниите, които използват тази технология, включват Twitter, Spotify, Netflix, Linkedin, Yahoo и др.

7. Apache Kafka : Известна със своята публикация-абониране или pub-sub, както е популярно известна като, е система за брокери с асинхронни съобщения за директни съобщения, която се използва за поглъщане и извършване на обработка на данни в поточно предаване на данни в реално време. Той също така предвижда период на запазване и данните могат да бъдат канализирани чрез механизъм производител-потребител. Това е една от най-популярните стрийминг платформи, която е много подобна на корпоративната система за съобщения или опашката за съобщения. Kafka стартира много подобрения до този момент и един основен вид е този на Kafka confluent, който осигурява допълнително ниво на свойства на Kafka, като Registry Schema, Ktables, KSql и др. Той е разработен от общността на Apache Software през 2011 г. и е написано на Java. Компаниите, които използват тази технология, включват Twitter, Spotify, Netflix, Linkedin, Yahoo и др.

8. Splunk : Splunk се използва за улавяне, съпоставяне и индексиране на поточни данни в реално време от хранилище за търсене, от което може да генерира отчети, графики, табла за управление, сигнали и визуализации на данни. Също така се използва за сигурност, съответствие и управление на приложенията, а също и за уеб анализи, генериране на бизнес прозрения и бизнес анализ. Той е разработен от Splunk в Python, XML, Ajax.

8. Splunk : Splunk се използва за улавяне, съпоставяне и индексиране на поточни данни в реално време от хранилище за търсене, от което може да генерира отчети, графики, табла за управление, сигнали и визуализации на данни. Също така се използва за сигурност, съответствие и управление на приложенията, а също и за уеб анализи, генериране на бизнес прозрения и бизнес анализ. Той е разработен от Splunk в Python, XML, Ajax.

9. Apache Spark : Сега идва най-критичната и най-чаканата технология в областта на технологиите за големи данни, т.е. Apache Spark. Вероятно е сред най-търсените днес и използва Java, Scala или Python за своята обработка. Това се използва за обработка и обработка на поточни данни в реално време чрез използване на Spark Streaming, който използва операции за пакетиране и прозорци, за да се случи това. Spark SQL се използва за създаване на рамки от данни, набори от данни върху RDD, като по този начин осигурява добър аромат на трансформации и действия, които формират неразделен компонент на Apache Spark Core. Други компоненти като Spark Mllib, R и graphX също са полезни в случай на анализ и правене на машинно обучение и наука за данни. Техниката за изчисляване в паметта е това, което го отличава от другите инструменти и компоненти и поддържа голямо разнообразие от приложения. Той е разработен от фондацията на Apache Software основно на езика на Java.

9. Apache Spark : Сега идва най-критичната и най-чаканата технология в областта на технологиите за големи данни, т.е. Apache Spark. Вероятно е сред най-търсените днес и използва Java, Scala или Python за своята обработка. Това се използва за обработка и обработка на поточни данни в реално време чрез използване на Spark Streaming, който използва операции за пакетиране и прозорци, за да се случи това. Spark SQL се използва за създаване на рамки от данни, набори от данни върху RDD, като по този начин осигурява добър аромат на трансформации и действия, които формират неразделен компонент на Apache Spark Core. Други компоненти като Spark Mllib, R и graphX също са полезни в случай на анализ и правене на машинно обучение и наука за данни. Техниката за изчисляване в паметта е това, което го отличава от другите инструменти и компоненти и поддържа голямо разнообразие от приложения. Той е разработен от фондацията на Apache Software основно на езика на Java.

10. R език : R е език за програмиране и безплатна софтуерна среда, която се използва за статистически изчисления, а също и за графика на един от най-важните езици в R. Това е един от най-популярните езици сред учените за данни, миньорите на данни и практикуващи данни за разработване на статистически софтуер и главно в анализа на данни.

10. R език : R е език за програмиране и безплатна софтуерна среда, която се използва за статистически изчисления, а също и за графика на един от най-важните езици в R. Това е един от най-популярните езици сред учените за данни, миньорите на данни и практикуващи данни за разработване на статистически софтуер и главно в анализа на данни.

Нека сега обсъдим технологиите, свързани с визуализацията на данни.

11. Tableau: Това е най-бързото и мощно нарастващо средство за визуализация на данни, което се използва в областта на бизнес разузнаването. Анализът на данни е много бърза машина, която е възможна с помощта на Tableau и се създават визуализации под формата на работни листове и табла. Той е разработен от компанията tableau през 2013 г. и е написан на Python, C ++, Java и C. Компаниите, които използват Tableau са: QlikQ, Oracle Hyperion, Cognos и др.

11. Tableau: Това е най-бързото и мощно нарастващо средство за визуализация на данни, което се използва в областта на бизнес разузнаването. Анализът на данни е много бърза машина, която е възможна с помощта на Tableau и се създават визуализации под формата на работни листове и табла. Той е разработен от компанията tableau през 2013 г. и е написан на Python, C ++, Java и C. Компаниите, които използват Tableau са: QlikQ, Oracle Hyperion, Cognos и др.

12. Plotly : Plotly се използва главно за правене на графики и свързани компоненти по-бързи и по-ефективни. Той има по-богат набор от библиотеки и API, като MATLAB, Python, R, Arduino, Julia и др. Това може да се използва интерактивно в тетрадката на Jupyter и Pycharm и може да се използва за стил на интерактивни графики. За първи път е разработен през 2012 г. и е написан на JavaScript. Няколко компании, които използват Plotly, са паладини, битбанк и т.н.

12. Plotly : Plotly се използва главно за правене на графики и свързани компоненти по-бързи и по-ефективни. Той има по-богат набор от библиотеки и API, като MATLAB, Python, R, Arduino, Julia и др. Това може да се използва интерактивно в тетрадката на Jupyter и Pycharm и може да се използва за стил на интерактивни графики. За първи път е разработен през 2012 г. и е написан на JavaScript. Няколко компании, които използват Plotly, са паладини, битбанк и т.н.

заключение

В този пост ние проучихме най-добрите технологии за големи данни, които са широко използвани днес. Дано ви е харесало. Продължавайте да ни следите за още публикации като тези.

Препоръчителни статии

Това е ръководство за Big Data Technologies. Тук сме обсъдили въведение и видове големи данни технологии. Можете да разгледате и другите ни предложени статии, за да научите повече -

- Какво е Splunk Tool?

- R срещу Python

- Какво е Matlab?

- Какво е MongoDB?

- Стъпки, които да следвате при тестване на мейнфрейм

- Видове съединения в Spark SQL (Примери)

- Научете различните видове инструменти Kafka