Въведение в голямата архитектура на данни

Когато става въпрос за управление на тежки данни и извършване на сложни операции върху тези масивни данни, възниква необходимост от използване на големи инструменти и техники за данни. Когато казваме, че използваме инструменти и техники за големи данни, ние ефективно означаваме, че искаме да използваме различни софтуер и процедури, които се намират в екосистемата с големи данни и нейната сфера. Няма генерично решение, което да се предоставя за всеки случай на употреба и следователно трябва да бъде изработено и направено по ефективен начин според бизнес изискванията на конкретна компания. По този начин възниква необходимост от използване на различни архитектури на големи данни, тъй като комбинацията от различни технологии ще доведе до постигане на резултата от случая на използване. Чрез създаване на фиксирана архитектура може да се гарантира, че ще бъде осигурено жизнеспособно решение за зададения случай на използване.

Какво е архитектурата на големи данни?

- Тази архитектура е проектирана по такъв начин, че да обработва процеса на поглъщане, обработката на данните и анализът на данните се извършва, което е твърде голямо или сложно за работа с традиционните системи за управление на бази данни.

- Различните организации имат различни прагове за своите организации, някои имат няколкостотин гигабайта, докато за други дори някои терабайти не са достатъчно добра стойност на прага.

- Поради това събитие, което се случва, ако разгледате стоковите системи и стоковото съхранение, стойностите и разходите за съхранение намаляха значително. Има огромно разнообразие от данни, които изискват различни начини да бъдат удовлетворени.

- Някои от тях са свързани с партиди данни, които идват в определен момент и следователно се изисква задачите да бъдат планирани по подобен начин, докато други принадлежат към класа на потока, където трябва да бъде изграден поточен тръбопровод в реално време, който да обслужва всички изисквания. Всички тези предизвикателства са решени от архитектурата на големи данни.

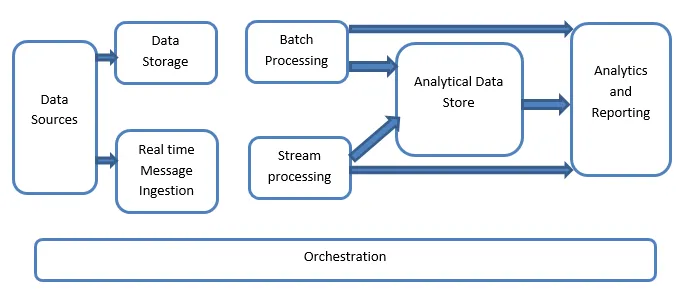

Обяснение на голямата архитектура на данни:

Системите с големи данни включват повече от един вид натоварване и те са широко класифицирани, както следва:

- Когато големите източници на данни са в покой, се включва пакетна обработка.

- Голяма обработка на данни в движение за обработка в реално време.

- Изследване на интерактивни инструменти и технологии за големи данни.

- Машинно обучение и прогнозен анализ.

1. Източници на данни

Източниците на данни включват всички онези златни източници, от които е изграден тръбопроводът за извличане на данни и следователно това може да се каже, че е отправна точка на тръбопровода с големи данни.

Примерите включват:

(i) Магазини от данни на приложения като тези като релационни бази данни

(ii) Файловете, които се произвеждат от редица приложения и до голяма степен са част от статични файлови системи като уеб базирани сървърни файлове, генериращи регистрационни файлове.

(iii) IoT устройства и други източници на данни в реално време.

2. Съхранение на данни

Това включва данните, които се управляват за пакетно изградени операции и се съхраняват във файловите хранилища, които се разпространяват в природата и също могат да държат големи обеми от големи формати, поддържани от големи формати. Нарича се езерото с данни. Това обикновено представлява частта, в която се предоставят нашите Hadoop съхранение като HDFS, Microsoft Azure, AWS, GCP съхранения, заедно с контейнери blob.

3. Партидна обработка

Всички данни са разделени в различни категории или парчета, което използва дългогодишни задачи, използвани за филтриране и обобщаване, както и за подготовка на данни за обработено състояние за анализ. Тези задачи обикновено използват източници, обработват ги и осигуряват изхода на обработените файлове към новите файлове. Пакетната обработка се извършва по различни начини, като се използват задания на Hive или U-SQL базирани задачи или чрез използване на Sqoop или Pig заедно с задания за персонализиран редуктор на карти, които обикновено са написани на която и да е от Java или Scala или която и да е друга език като Python.

4. Поглъщане на съобщения в реално време

Това включва, за разлика от пакетната обработка, всички онези поточни системи в реално време, които обслужват данните, които се генерират последователно и по фиксиран модел. Това често е просто март на данни или магазин, отговорен за всички входящи съобщения, които са изпуснати в папката, задължително използвани за обработка на данни. Съществуват обаче повечето решения, които изискват нуждата от хранилище за поглъщане на базата на съобщения, което действа като буфер на съобщения и също така поддържа обработка на базата на мащаби, осигурява сравнително надеждна доставка, заедно с други семантики на опашката за съобщения. Опциите включват такива като Apache Kafka, Apache Flume, хъбовете за събития от Azure и т.н.

5. Потокова обработка

Има малка разлика между приемането на съобщения в реално време и обработката на потока. Първият взема предвид приетите данни, които се събират отначало и след това се използват като вид инструмент за публикуване. От друга страна, поточната обработка се използва за обработка на всички онези поточни данни, които се срещат в прозорци или потоци и след това записва данните в изходната мивка. Това включва Apache Spark, Apache Flink, Storm и т.н.

6. Магазин на данни, базиран на Анализ

Това е хранилището на данни, което се използва за аналитични цели и следователно вече обработените данни се питат и анализират с помощта на инструменти за анализи, които могат да съответстват на BI решенията. Данните могат също да бъдат представени с помощта на технология за съхранение на данни NoSQL като HBase или каквато и да е интерактивна употреба на база данни на кошери, която може да осигури абстракция на метаданните в хранилището на данни. Инструментите включват Hive, Spark SQL, Hbase и т.н.

7. Отчитане и анализ

Прозренията трябва да се генерират върху обработените данни и това се прави ефективно от инструментите за докладване и анализ, който използва вградената им технология и решение за генериране на полезни графики, анализи и прозрения, полезни за бизнеса. Инструментите включват Cognos, Hyperion и т.н.

8. Оркестрация

Големите базирани на данни решения се състоят от операции, свързани с данни, които се повтарят по своя характер и също са капсулирани в работните процеси, които могат да преобразуват изходните данни, а също така да преместват данни по източници, както и потъващите и зареждани в магазините и да вкарват в аналитични единици. Примерите включват Sqoop, oozie, фабрика за данни и т.н.

заключение

В тази публикация четем за голямата архитектура на данни, която е необходима, за да бъдат внедрени тези технологии във фирмата или организацията. Надявам се, че сте харесали нашата статия.

Препоръчителни статии

Това е ръководство за архитектурата на големи данни. Тук обсъждаме какво са големи данни? а също така обяснихме архитектурата на големите данни заедно с блок-схемата. Можете да разгледате и другите ни предложени статии, за да научите повече -

- Технологии за големи данни

- Анализ на големи данни

- Кариери в големи данни

- Въпроси за интервю с големи данни

- Топ 8 устройства на IoT, които трябва да знаете

- Видове съединения в Spark SQL (Примери)