Въведение в класификационните алгоритми

Тази статия за класификационните алгоритми поставя преглед на различни методи за класификация, които обикновено се използват в техники за извличане на данни с различни принципи. Класификацията е техника, която категоризира данните в отделен брой класове и от своя страна етикетът се приписва на всеки клас. Основната цел на класификацията е да се идентифицира класът за въвеждане на нови данни чрез анализ на обучението, като се виждат правилни граници. По принцип прогнозирането на целевия клас и горния процес се нарича класификация.

Например ръководството на болницата записва името, адреса, възрастта на пациента, предишната история на здравето на пациента, за да ги диагностицира, това помага да се класифицират пациентите. Те могат да бъдат характеризирани в две фази: фаза на обучение и фаза на оценяване. Модели на фаза на обучение, базата на подхода дава данни за обучение, докато фазата на оценка прогнозира изхода за дадените данни. Можем да намерим техните приложения в имейл спам, прогнозиране на банков заем, разпознаване на реч, анализ на чувството. Техниката включва математическа функция f с вход X и изход Y.

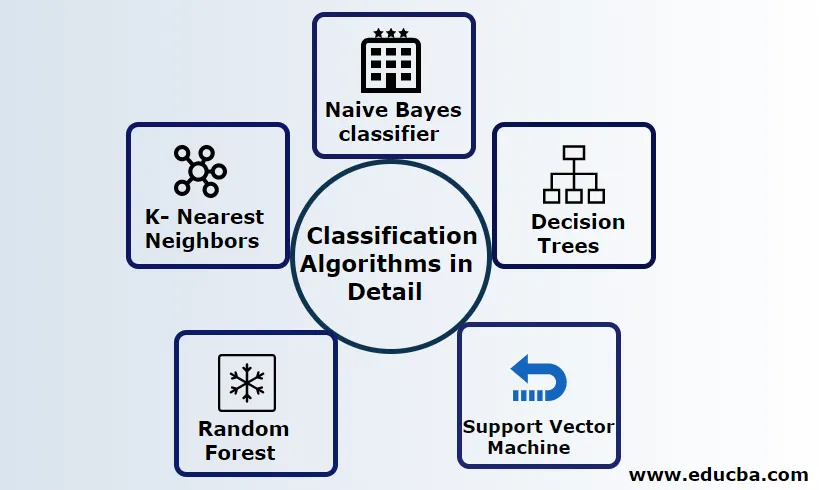

Обяснете подробно алгоритмите за класификация

Класификацията може да се извърши както на структурирани, така и на неструктурирани данни. Класификацията може да бъде категоризирана

- Naive Bayes класификатор

- Дървета на решенията

- Подкрепа Векторна машина

- Случайна гора

- K- Най-близките съседи

1) Naive Bayes класификатор

Това е алгоритъм, базиран на теоремата на Байес, една от статистическите класификации и изисква малко количество данни за обучение за оценка на параметрите, известни също като вероятностни класификатори. Той се счита за най-бързият класификатор, високо мащабируем и обработва както дискретни, така и непрекъснати данни. Този алгоритъм се използва за прогнозиране в реално време. Съществуват различни видове наивни класификатори, мултиномиални наивни байеси, наивни байели на Бернули, наивни гаусски.

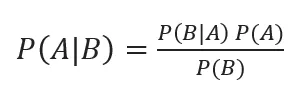

Байесова класификация със задни вероятности е дадена от

Където A, B са събития, P (A | B) - задни вероятности.

Ако две стойности са независими една от друга,

P (A, B) = P (A) P (B)

Naive Bayes може да се изгради с помощта на библиотеката python. Прогнозите на Naive са независими, въпреки че се използват в препоръчителни системи. Те се използват в много приложения в реално време и добре се използват при класифицирането на документи.

Предимства:

Предимства са, че изискват много по-малко изчислителна мощност, приета при проблеми с предсказването на множество класове, точно работят върху големи набори от данни.

Недостатък:

Основният недостатък на този класификатор е, че те ще присвоят нулева вероятност. И те имат функции, с които са независими един от друг.

2) Дърво на решения

Това е модел на подход отгоре надолу, като структурата на диаграмата обработва данни с големи размери. Резултатите се прогнозират въз основа на дадената входна променлива. Дърво на решение, съставено от следните елементи: Корен, много възли, клони, листа. Коренният възел прави дяла въз основа на стойността на атрибута на класа, вътрешният възел взема атрибут за по-нататъшна класификация, клоните вземат решение за разделяне на възлите на листни възли, накрая, листовите възли ни дават крайния резултат. Сложността на времето на дървото за решения зависи от броя на записите, атрибутите на данните от обучението. Ако дървото на решения е твърде дълго, е трудно да получите желаните резултати.

Предимство: Те се прилагат за прогнозна анализа за решаване на проблемите и се използват ежедневно при ежедневните дейности, за да се избере целта въз основа на анализ на решения. Автоматично изгражда модел въз основа на изходните данни. Най-добре в работата с липсващи стойности.

Недостатък: Размерът на дървото е неконтролируем, докато има някои критерии за спиране. Поради своята йерархична структура дървото е нестабилно.

3) Подкрепа Векторна машина

Този алгоритъм играе жизненоважна роля при проблемите с класификацията и най-често машинното обучение, контролирано от контролирани алгоритми. Това е важен инструмент, използван от изследователя и учения с данни. Този SVM е много лесен и процесът му е да се намери хиперплан в точки от данни за N-мерни пространства. Хиперпланите са граници на решения, които класифицират точките от данни. Целият този вектор пада по-близо до хиперплана, максимизирайки границата на класификатора. Ако маржът е максимален, най-ниската е грешката за обобщаване. Изпълнението им може да се извърши с ядрото, като се използва python с някои обучителни набори от данни. Основната цел на SVM е да обучи обект в определена класификация. SVM не е ограничен да стане линеен класификатор. SVM е предпочитан повече от всеки класификационен модел поради тяхната функция на ядрото, което подобрява изчислителната ефективност.

Предимство: Те са много за предпочитане заради по-малката си изчислителна мощност и ефективната точност. Ефективен в пространството с големи размери, добра ефективност на паметта.

Недостатък: Ограничения в скоростта, ядрото и размера

4) Случайна гора

Това е мощен алгоритъм за машинно обучение, базиран на подхода за учене в ансамбъла. Основният градивен елемент на Random Forest е дървото на решения, използвано за изграждане на прогнозни модели. Демонстрацията на работа включва създаване на гора от дървета с произволни решения, а процесът на подрязване се извършва чрез задаване на спирателни разцепления, за да се получи по-добър резултат. Случайната гора се реализира с помощта на техника, наречена пакетиране за вземане на решения. Това пакетиране предотвратява препълването на данни чрез намаляване на отклоненията подобно на този случаен случай може да постигне по-голяма точност. Окончателното прогнозиране се взема средно от много дървета за решения, т.е. чести прогнози. Случайната гора включва много случаи на използване като прогнози на фондовата борса, откриване на измама, прогнози за новини.

Предимства:

- Не изисква голяма обработка за обработка на наборите от данни и много лесен модел за изграждане. Осигурява по-голяма точност, помага при решаване на предсказващи проблеми.

- Работи добре в боравенето с липсващи стойности и автоматично разпознава външен вид.

Недостатък:

- Изисква високи изчислителни разходи и висока памет.

- Изисква много повече времеви период.

5) K- Най-близките съседи

Тук ще обсъдим K-NN алгоритъма с контролирано обучение за CART. Те използват K положително малки числа; обект се присвоява на класа въз основа на съседите или ще кажем назначаване на група, като наблюдаваме в коя група лежи съседът. Това се избира чрез измерване на разстояние Евклидово разстояние и груба сила. Стойността на K може да се намери с помощта на процеса на настройка. KNN не предпочита да научи какъвто и да е модел за обучение на нов набор от данни и използване на нормализация за пренастройване на данни.

Предимство: Дава ефективни резултати, ако данните за обучението са огромни.

Недостатък: Най-големият проблем е, че ако променливата е малка, тя работи добре. Второ, избирането на фактор K, докато класифицира.

заключение

В заключение, ние преминахме през възможностите на различни алгоритми за класификация, все още действа като мощен инструмент в конструирането на функции, класификацията на изображенията, която играе чудесен ресурс за машинно обучение. Класификационните алгоритми са мощни алгоритми, които решават трудни проблеми.

Препоръчителни статии

Това е ръководство за класификационни алгоритми в машинното обучение. Тук обсъждаме, че Класификацията може да се извърши както върху структурирани, така и върху неструктурирани данни. Можете да разгледате и другите ни предложени статии -

- Алгоритми за маршрутизиране

- Алгоритъм на клъстеризация

- Процес за извличане на данни

- Алгоритми за машинно обучение

- Най-използваните техники на ансамбълното обучение

- C ++ Алгоритъм | Примери за C ++ алгоритъм