Въведение в командите Hadoop fs

В тази статия ще преминем през командите за обработка на файлове на HADOOP, който се използва за управление на файловете през конзолата.

Ще ви трябва Linux система и най-новата версия на Hadoop. За да отпечатаме версията на Hadoop, за да знаем от кого е построена версията, стойността на контролната сума, която просто трябва да изпълним по-долу командата след влизане в платформата Hadoop.

Команда: Hadoop версия

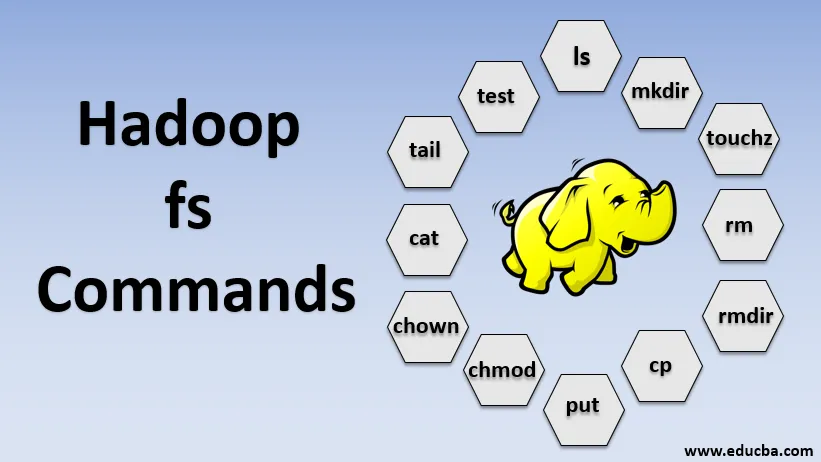

Командите на Hadoop fs

Сега, нека научим как да използваме HADOOP fs команди.

Ще започнем с основите. Просто напишете тези команди в PUTTY или в която и да е конзола, която ви е удобна.

1. hadoop fs -ls

За директория тя връща списъка с файлове и директории, докато за файл връща статистическите данни за файла.

hadoop fs -lsr: това е за рекурсивно изброяване на директории и файлове под конкретни папки.

- Пример : hadoop fs -ls / или hadoop fs -lsr

- -d: Използва се за изброяване на директории като обикновени файлове.

- -h: Използва се за форматиране на размерите на файлове по начин, който може да се чете от човека, отколкото просто броя на байтовете.

- -R: Използва се за рекурсивен списък на съдържанието на директории.

2. hadoop fs -mkdir

Тази команда приема пътя като аргумент и създава директории в hdfs.

- Пример : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Той създава празен файл и не използва място

- Пример: hadoop fs -touchz URI

4. hadoop fs -rm

Изтрийте файловете, посочени като аргумент. Трябва да посочим опцията -r, за да изтрием цялата директория. И ако е зададена опцията -skipTrash, тя ще пропусне кошчето и файлът ще бъде изтрит веднага.

- Пример : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Той премахва файлове и разрешения на директории и поддиректории. По същество това е разширената версия на Hadoop fs -rm.

6. hadoop fs -cp

Той копира файла от едно място на друго

- Пример : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Той копира файла от edgenode в HDFS.

8. hadoop fs -put

Той копира файла от edgenode в HDFS, той е подобен на предишната команда, но поставя също така чете вход от стандартен вход stdin и пише на HDFS

- Пример : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: Флагът запазва достъпа, времето за модификация, собствеността и режима.

hadoop fs -put -f: Тази команда презаписва местоназначението, ако файлът вече съществува преди копието.

9. hadoop fs -moveFromLocal

Подобно е на копирането от локално, с изключение на това, че изходният файл се изтрива от локалния едгенод след като се копира в HDFS

- Пример : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Той копира файла от HDFS в edgenode.

- Пример : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Тази команда ни помага да променим достъпа до файл или директория

- Пример : hadoop fs -chmod (-R) (път)

12. hadoop fs -шон

Тази команда ни помага да променим собствеността на файл или директория

- Пример : hadoop fs -chown (-R) (СОБСТВЕНИК) (:( GROUP)) PATH

13. hadoop fs -cat

Той отпечатва съдържанието на HDFS файл на терминала

- Пример : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Той показва последния KB от HDFS файла към stdout

- Пример : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

Тази команда се използва за тестови операции с файлове в HDFS, тя връща 0, ако е истина.

- - e: проверява дали файлът съществува.

- -z: проверява дали файлът е с нулева дължина

- -d / -f: проверява дали пътят съответно е директория / файл

Тук подробно обсъждаме един пример

- Пример : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Показва размерите на файлове и директории, съдържащи се в дадената директория, или дължината на файла, в случай че е файл

17. hadoop fs -df

Показва свободно пространство

18. hadoop fs -checksum

Връща информацията за контролната сума на файл

19. hadoop fs -getfacl

Той показва списъка за контрол на достъпа (ACL) на конкретния файл или директория

20. hadoop fs -count

Той отчита броя на директории, файлове и байтове под пътя, който съответства на зададения модел на файла.

21. hadoop fs -setrep

Променя коефициента на репликация на файл. И ако пътят е директория, тогава командата променя фактора на репликация на всички файлове в директорията.

- Пример : hadoop fs -setrep -R / user / datahub: използва се за приемане на способността за връщане назад и няма ефект.

hadoop fs - setrep -w / user / datahub : изчаква завършването на репликацията

22. hadoop fs -getmerge

Той свързва HDFS файлове в източника в локалния файл назначение

- Пример : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Добавя един източник или няколко източника от локалната файлова система до местоназначението.

- Пример : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Той отпечатва статистическите данни за файла или директорията.

- Пример : hadoop fs -stat (формат)

Заключение - Hadoop fs Команди

Така че, ние преминахме през почти всички команди, които са необходими за работа с файлове и преглед на данните вътре във файловете. Можете да модифицирате вашите файлове и да прехвърляте данни в платформата Hadoop сега.

Препоръчителни статии

Това е ръководство за Hadoop fs командите. Тук обсъждаме въвеждането на Hadoop fs команди заедно с неговия пример подробно. Можете също да разгледате следните статии, за да научите повече-

- Инсталирайте Hadoop

- Hadoop инструменти

- Hadoop Архитектура

- Компоненти на Hadoop

- Hadoop fs Команди