Какво представлява екосистемата Apache Hadoop?

Apache Hadoop Ecosystem е рамка или платформа за данни с отворен код, назначена да запазва и изследва огромните колекции от данни неструктурирани. В цял свят има много данни, които се задвижват от множество цифрови платформи с водещата иновативна технология за големи данни. Нещо повече, Apache Hadoop беше първият, който получи този поток от иновации.

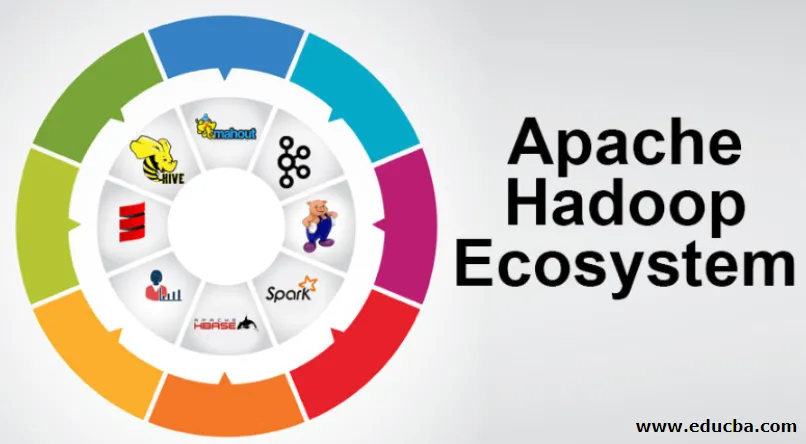

Какво се състои от архитектурата / екосистемата на Hadoop Data?

Екосистемата Hadoop не е език за програмиране или услуга, тя е рамка или платформа, която се грижи за проблеми с големи данни. Можете да го идентифицирате като пакет, който обгръща различни услуги като съхраняване, поглъщане, поддръжка и анализ в него. След това разгледайте и вземете кратка мисъл относно това как работят услугите изключително и в сътрудничество. Архитектурата на Apache Hadoop се състои от различни иновации и елементи на Hadoop, чрез които дори сложните информационни проблеми могат да бъдат решавани ефективно.

Следва изобразяването на всяка част: -

1) Namenode: Той ръководи процеса на информация

2) Датанод: Той съставя информацията за локално съхранение. Записването на цялата информация на едно място не се препоръчва непрекъснато, тъй като може да доведе до загуба на информация в случай на прекъсване.

3) Проследяващ задачи: Те получават задължения, разпределени на робския възел

4) Карта: Тя взема информация от поток и всеки ред се обработва разделен, за да го раздели в различни полета

5) Намаляване: Тук полетата, придобити чрез Картата, са събрани или свързани помежду си

Екосистема Apache Hadoop - стъпка по стъпка

Всеки елемент от екосистемата Hadoop, тъй като специфични аспекти са очевидни. Цялостната перспектива на структурата на Hadoop предлага забележително качество на разпределените файлови системи (HDFS), Hadoop ПРЕЖДА, Hadoop MapReduce и Hadoop MapReduce от екосистемата на Hadoop. Hadoop дори дава на всяка Java библиотека, значими записи от Java, отражение на ниво OS, предимства и скриптове за работа с Hadoop, Hadoop YARN е метод за бизнес очертаване и управление на групи ресурси. В конфигурацията на Hadoop HDFS осигурява пропуск на висока пропускателна способност на информацията за приложението, а Hadoop MapReduce предоставя паралелно изготвяне на обширни асортименти от данни на базата на YARN.

Преглед на екосистемата на Apache Hadoop

Това е основен предмет, който трябва да разберете, преди да започнете да работите с Hadoop Ecosystem. По-долу са основните компоненти:

- HDFS: Това е централната част на Hadoop Ecosystem и може да спести огромно количество неструктурирана, структурирана и полуструктурирана информация.

- ПРЕЖДЪН: Прилича на ума на екосистемата Hadoop и всички обработки се извършват директно тук, което може да включва разпределение на активи, планиране на работа и подготовка за действия.

- MapReduce: Това е смесица от два процеса, описани като Map and Reduce и се състои по същество от подготовка на части, съставящи огромни информационни колекции, използващи паралелни и разпръснати алгоритми в екосистемата Hadoop.

- Apache Pig: Това е език на процедурата, който се използва за паралелно обработване на приложения за обработка на огромни информационни колекции в състояние Hadoop и този език е опция за програмиране на Java.

- HBase: Това е отворен код и не асоциирана или NoSQL база данни. По този начин тя укрепва всички видове информация, така че може да се справи с всеки тип информация в рамките на Hadoop.

- Mahout, Spark MLib: Mahout се използва за машинно обучение и дава природа на създаването на приложения за машинно обучение.

- Zookeeper: За да се справите с групите, човек може да използва Zookeeper, иначе той се нарича господар на координацията, което може да даде надеждни, бързи и подредени оперативни администрации за групите Hadoop.

- Oozie: Apache Oozie управлява график на работа и работи като сигнал и часовни услуги в екосистемата Hadoop.

- Ambari: Това е начинание на Apache Software Foundation и може да изпълнява прогресивно гъвкавата екосистема Hadoop.

Препоръка Hadoop:

Помислете за YARN като ума на вашата Hadoop Ecosystem. Той възпроизвежда цялата обработка на вашите операции чрез разпределяне на активи и мита за планиране.

Той има два забележителни сегмента, които са ResourceManager и NodeManager.

- ResourceManager: - Това отново е основен възел в операционното подразделение. Той получава подготвителните запитвания и след това предава частите запитвания съответно към съответните NodeManagers, където се случва истинското обработване.

- NodeManagers: - Те са инсталирани на всеки DataNode. Той отговаря за изпълнението на задание за всяка DataNode.

Как работи apache Hadoop?

- Той е предназначен да се изкачи от отделни сървъри до огромно количество машини, всяка от които осигурява локални изчисления и капацитет. Вместо да зависи от оборудването за предаване на висока достъпност, самата библиотека е предназначена да различава и да се справя с разочарованията в приложния слой, така че да предава изключително достъпна услуга през куп компютри, всеки от които може да е склонен към разочарования.

- Погледнете по-нататък обаче и в работата има значително увеличаващ се чар. Hadoop е напълно модулен, което означава, че можете да замените практически всеки от неговите сегменти за алтернативен софтуерен инструмент. Това прави архитектурно фантастично приспособима, също толкова мощна и ефективна.

Apache Hadoop Spark:

- Apache Spark е система за анализ на информация в реално време в разпръснати изчислителни настройки. Той реализира изчисления в паметта, за да изгради скоростта на работа с информация.

- Той е по-бърз за работа с обширна информация, тъй като използва изчисления в паметта и различни подобрения. По тези линии тя изисква висока сила на обработка.

Как работи Apache Pig?

- Apache Pig е благоприятна система Yahoo е разработена да изследва огромни информационни позиции ефективно и гладко. Той дава някои езици от най-високо ниво на информационен поток Pig Latin, който е подобрен, разширим и лесен за използване.

- Изключителният компонент на програмите за свине, в който техният състав е достъпен за съществена паралелизация, което прави това просто да се грижи за значителни информационни колекции.

Случай за използване на свине:

- Информацията за частното здравеопазване на дадено лице е частна и не трябва да се разкрива на други хора. Тези данни трябва да бъдат скрити, за да се запази секретността, но информацията за медицинските услуги е огромна до степен, че признаването и изключването на индивидуалната информация за здравеопазването е от съществено значение. Apache Pig може да се използва при такива условия за депризнаване на здравните данни.

Заключение:

- Очертано е да се изкачи от само един сървър до огромно количество машини, всички осигуряващи изчисления и капацитет наблизо. Погледнете обаче по-нататък и в работата има много по-голямо очарование.

- Hadoop е напълно модулен, което означава, че можете да търгувате практически всяка от неговите части за алтернативен софтуерен инструмент. Това прави структурата фантастично приспособима, също толкова мощна и ефективна.

Препоръчителни статии

Това е ръководство за екосистемата Apache Hadoop. Тук сме обсъдили какво е Apache Hadoop Ecosystem? преглед на архитектурата на Hadoop и функционирането на екосистемата Hadoop. Можете да разгледате и другите ни предложени статии, за да научите повече -

- Компоненти на екодосистемата Hadoop

- Как да инсталирате Apache

- Обучение за искри Apache

- Кариера в Хадоп