Въведение в рамката на Hadoop

Преди да се потопим дълбоко в техническата рамка на Hadoop, ще започнем с прост пример.

Има ферма, която прибира домати и ги съхранява в един единствен склад за съхранение, сега с нарастващото търсене на зеленчуци, фермата започна да бере картофи, моркови - с нарастващото търсене имаше недостиг на фермери, така че те наеха повече фермери. След известно време разбрали, че има недостиг в складовата зона - затова разпределили зеленчуците в различни зони за съхранение. Що се отнася до извличането на данните, всички те работят паралелно със собственото си пространство за съхранение.

И така, как тази история е свързана с големите данни?

По-рано имахме ограничени данни, с ограничения процесор и едно устройство за съхранение. Но след това генерирането на данни се увеличи, което доведе до голям обем и различни разновидности - структурирани, полуструктурирани и неструктурирани, Така че решението беше да се използва разпределено съхранение за всеки процесор, което даде възможност за лесен достъп до съхранение и достъп до данни.

Така че сега можем да заменим зеленчуците като различни видове данни и място за съхранение, както разпределените места за съхраняване на данните и различни работници, които са всеки процесор.

Така че Big data е предизвикателството и Hadoop играе ролята на Solution.

Hadoop

1. Решение за ГОЛЕМИ ДАННИ: тъй като се справя със сложностите с голям обем, скорост и разнообразие от данни.

2. Комплект от проекта с отворен код.

3. Съхранява надежден обем от данни надеждно и позволява огромни разпределени изчисления.

4. Основните атрибути на Hadoop са излишъкът и надеждността (абсолютно никаква загуба на данни).

5. Основно се фокусира върху пакетната обработка.

6. Работи със стоков хардуер - няма нужда да купувате специален скъп хардуер.

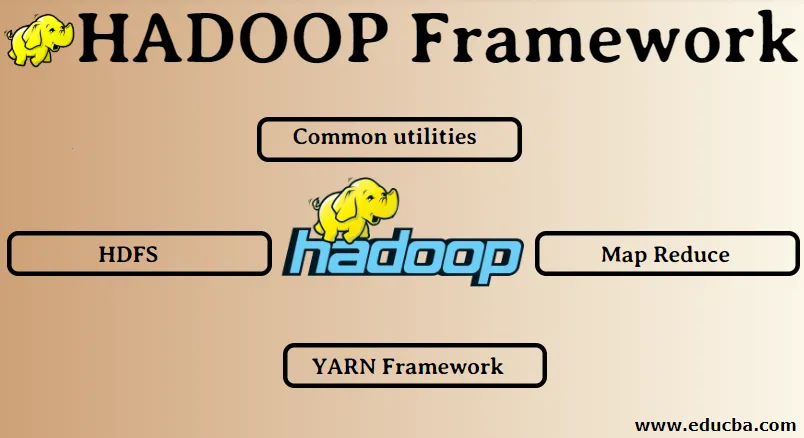

Рамка на Hadoop:

1. Общи комунални услуги

2. HDFS

3. Намаляване на картата

4. Рамка на ПРАВО

1. Общи комунални услуги:

Нарича се още Hadoop common. Това не са нищо друго освен библиотеки, файлове, скриптове и помощни програми на JAVA, които всъщност се изискват от другите компоненти на Hadoop за изпълнение.

2. HDFS: Разпределена файлова система Hadoop

Защо Hadoop е избрал да включи разпределена файлова система?

Нека да разберем това с един пример: Трябва да четем 1TB данни и имаме една машина с 4 I / O канала, всеки канал има 100MB / s, отне 45 минути, за да прочетем всички данни. Сега същото количество данни се чете от 10 машини всяка с 4 I / O канала, всеки канал има 100MB / s. Познайте колко време отне да прочетете данните? 4, 3 минути. HDFS решава проблема със съхранението на големи данни. Двата основни компонента на HDFS са NAME NODE и DATA NODE. Възелът с име е главният, може да имаме и вторичен възел с име, в случай че основният възел на име престане да работи, вторичният възел с име ще действа като резервно копие. Възелът на име основно поддържа и управлява възлите на данни чрез съхраняване на метаданни. Възелът на данни е подчинен, който в основата си е стоков хардуер. Можем да имаме множество възли за данни. Възелът за данни съхранява действителните данни. Този възел на данни поддържа коефициента на репликация, да предположим, че ако един възел от данни се спуска надолу, тогава данните могат да бъдат достъпни от другия репликиран възел от данни, следователно, достъпността на данните е подобрена и загубата на данни е предотвратена.

3. Намаление на картата:

Той решава проблема с обработката на големи данни. Нека разберем концепцията за карта намалява чрез решаване на този проблем в реалния свят. Компанията ABC иска да изчисли общите си продажби, съобразно града. Сега тук концепцията на хеш таблицата няма да работи, тъй като данните са в терабайти, така че ще използваме концепцията Map-Reduce.

Има две фази: а) MAP. б) НАМАЛЯВАНЕ

а) Карта : Първо, ще разделим данните на по-малки парчета, наречени картографи на базата на двойката ключ / стойност. Така че тук ключът ще бъде името на града, а стойността ще бъдат общите продажби. Всеки картограф ще получава данни за всеки месец, които дават име на града и съответните продажби.

б) Намаляване: Ще получи тези купчини данни и всеки редуктор ще бъде отговорен за градовете Север / Запад / Изток / Юг. Така работата на редуктора ще събира тези малки парченца и ще ги конвертира в по-големи количества (като ги добавя) за определен град.

4.YARN Рамка: Още един преговарящ ресурс.

Първоначалната версия на Hadoop имаше само два компонента: Map Reduce и HDFS. По-късно се разбра, че намаляването на картата не може да реши много големи проблеми с данни. Идеята беше да се премахнат отговорностите за управление на ресурсите и планиране на задачи от стария двигател за намаляване на картата и да се даде на нов компонент. Така е влязъл ПРЕЖЪРТЪТ в картината. Именно средният слой между HDFS и Map Reduce е отговорен за управлението на клъстерните ресурси.

Има две ключови роли за изпълнение: а) Планиране на работни места. б) Управление на ресурсите

а) График на заданията: Когато голям обем данни се дава за обработка, той трябва да бъде разпределен и разделен на различни задачи / задания. Сега JS решава на коя работа трябва да се даде основен приоритет, времевият интервал между две работни места, зависимостта между заданията, проверява дали няма припокриване между изпълняваните задачи.

б) Управление на ресурсите: За обработка на данните и за съхранение на данни имаме нужда от ресурси нали? Така мениджърът на ресурси предоставя, управлява и поддържа ресурсите за съхраняване и обработка на данните.

Така че сега вече сме наясно с концепцията на Hadoop и как тя решава предизвикателствата, създадени от ВЕЛИКИТЕ ДАННИ !!!

Препоръчителни статии

Това е ръководство за Hadoop Framework. Тук сме обсъдили и топ 4 рамки на Hadoop. Можете да разгледате и другите ни предложени статии, за да научите повече -

- Hadoop база данни

- Екосистема Hadoop

- Използване на Hadoop

- Работа на администратор на Hadoop

- Hadoop Administrator | Път за умения и кариера